Случайности не случайны… Всё решает вероятность событий!

В ЕГЭ по математике целых два задания на теорию вероятностей, поэтому стоит уделить ей в два раза больше внимания! Первое решается по основной формуле вероятности, а вот над вторым придётся подумать и вспомнить, какие бывают события.

Мы структурировали типы задач, которые могут попасться на экзамене, и сделали эту полезную шпаргалку с формулами и теорией — сохраняйте карточки, чтобы подготовка к ЕГЭ по математике была ещё продуктивнее.

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter. Мы обязательно поправим!

шпора по ТЕРВЕРУ (Шпоры по курсу — Теория вероятностей)

2018-01-112018-01-11СтудИзба

Описание файла

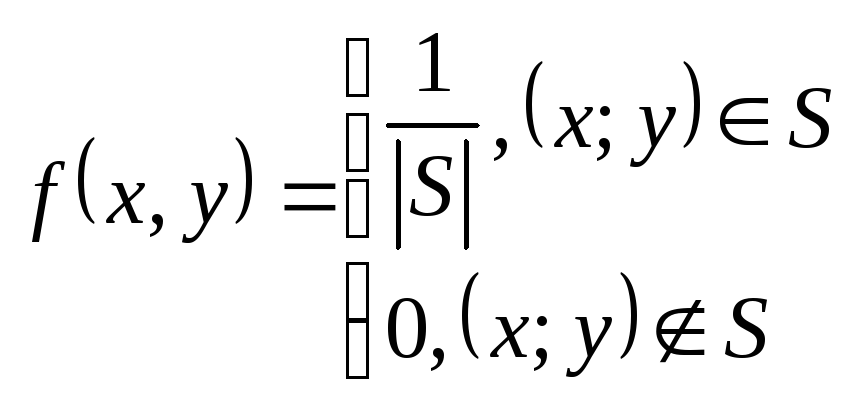

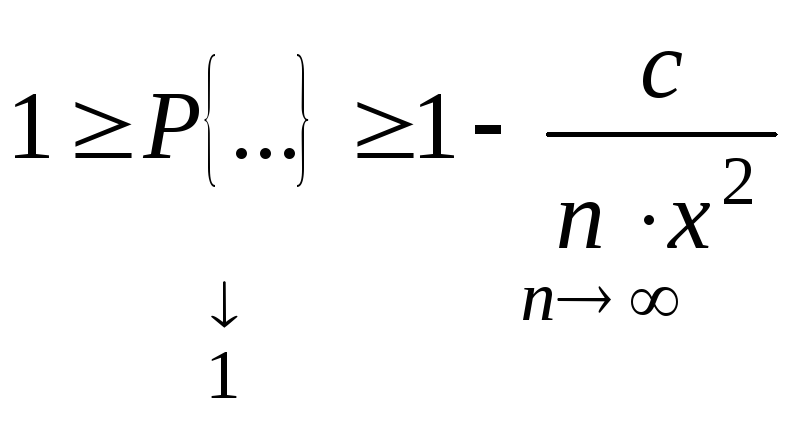

Файл «шпора по ТЕРВЕРУ» внутри архива находится в папке «Шпоры по курсу — Теория вероятностей». Документ из архива «Шпоры по курсу — Теория вероятностей»,

который расположен в категории «».

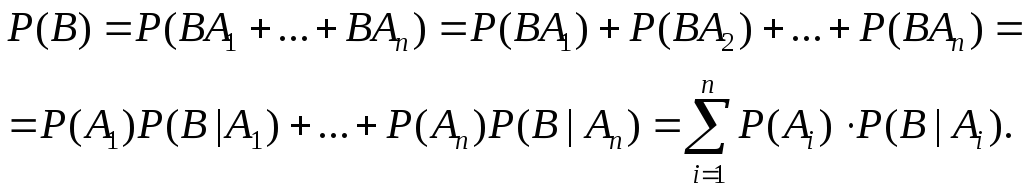

Всё это находится в предмете «теория вероятностей и математическая статистика» из 4 семестр, которые можно найти в файловом архиве РТУ МИРЭА.

Не смотря на прямую связь этого архива с РТУ МИРЭА, его также можно найти и в других разделах. Архив можно найти в разделе «к экзамену/зачёту», в предмете «теория вероятности» в общих файлах.

Онлайн просмотр документа «шпора по ТЕРВЕРУ»

Текст из документа «шпора по ТЕРВЕРУ»

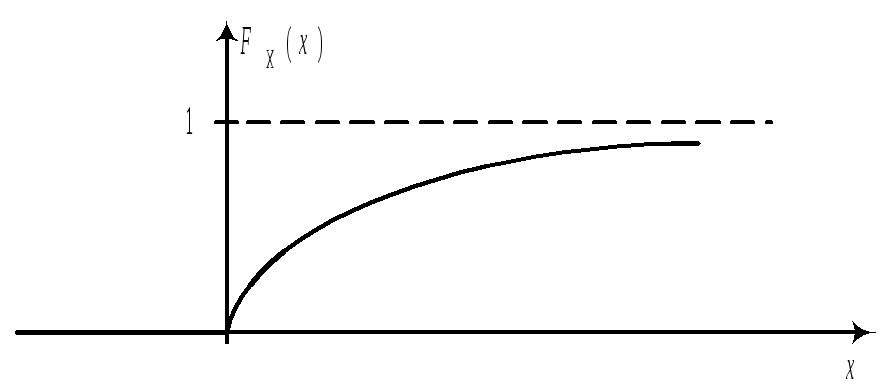

|

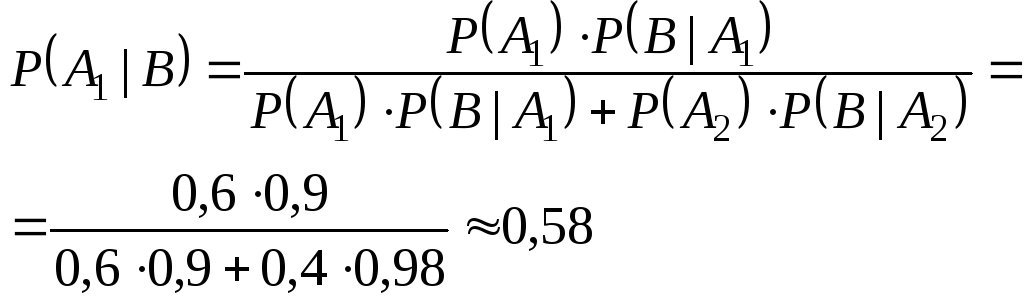

Теорема сложения несовместных: Теорема сложения совместных: P(A+B)=P(A)+P(B) P(A+B)=P(A)+P(B)-P(AB) Теорема умножения незав.соб. Теорема умножения зав.соб. P(AB)=P(A)*P(B) P(AB)=P(A)*PA(B) P(A)+P( Формула полной вероятности: верть соб.А к-е может наступить лишь при появл. 1 из несовм. соб.(гипотез)= P(A)=P(B1)*PB1(A)+P(B2)*PB2(A)+… Формула Байеса: событие А уже произошло, т.е. известен результат

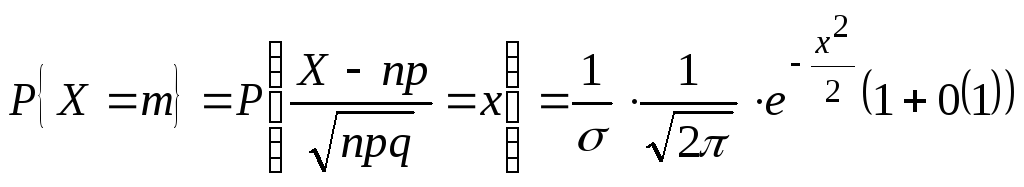

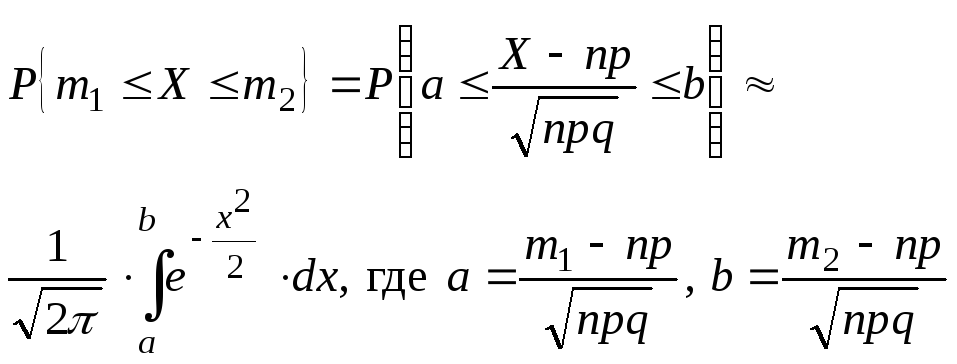

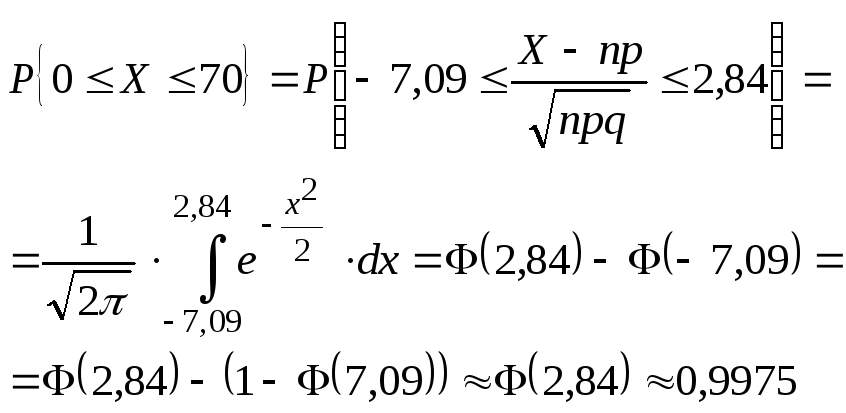

Формула Бернулли: вероятность того что в n незав. испыт-х. в каждом из которых вер-ть появ-я события = p , событие наступит ровно k раз = Менее k раз Pn(0)+Pn(1)+Pn(k-1) Более k раз Pn(k+1)+Pn(k+2)+…+Pn(n) или вычитать из единицы вероятность k раз!!! Не менее k раз Pn(k)+Pn(k+1)+…+Pn(n) Не более k раз Pn(0)+Pn(1)+…+Pn(k) Локальная теорема Лапласа: вероятность того что в n испытания в каждом из которых в-ть появления события =p, событие наступит k раз(без учёта последовательности)т.е. после 100 выстрелов, найти в-ть попадения 75 раз. Интегральная теорема Лапласа :в-ть того что в n событиях вер-ть каждого p, событие наступит не менее k1 раз но не более k2 раз.

|

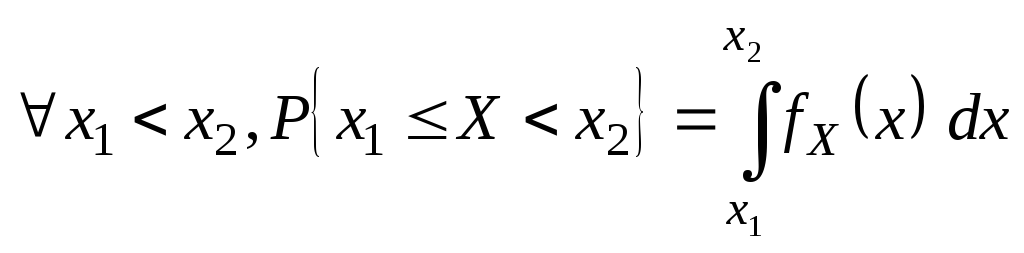

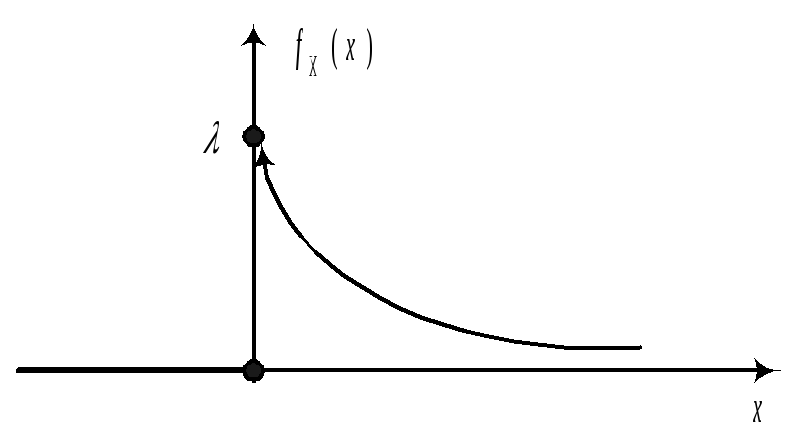

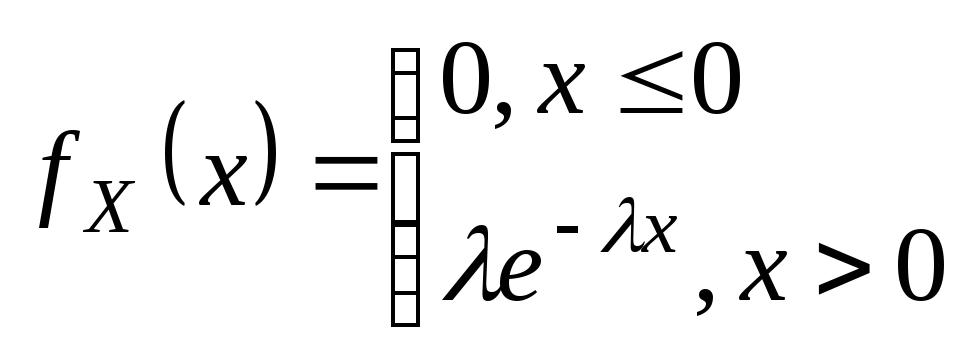

Плотность распределения вероятностей непрерывной случайной величины X называют функцию f(x) – первую производную от функции распределения F(x): Дисперсия через плотность для не прерывной случ.вел.:

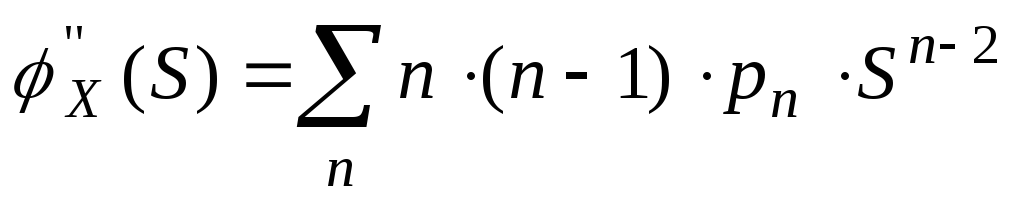

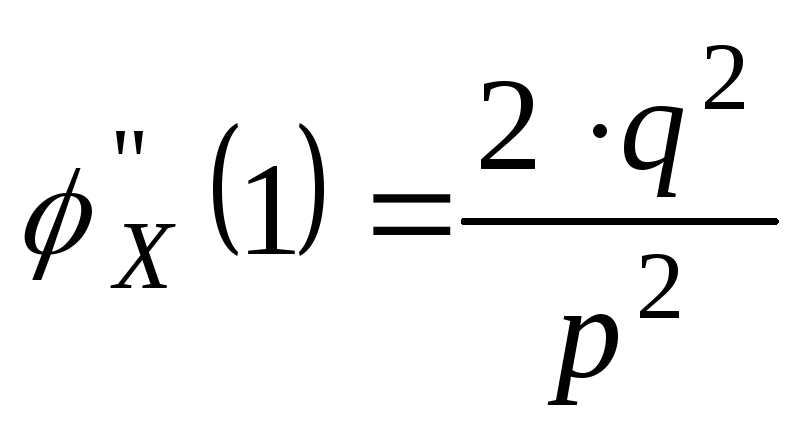

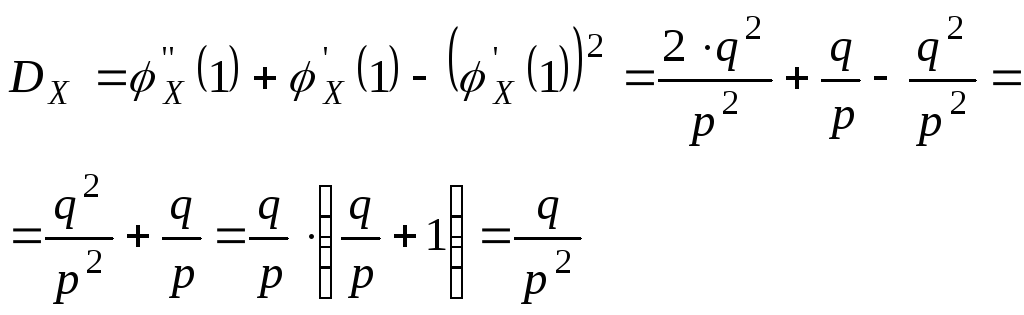

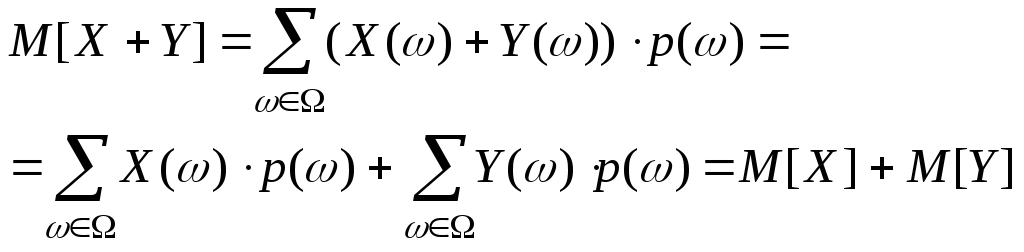

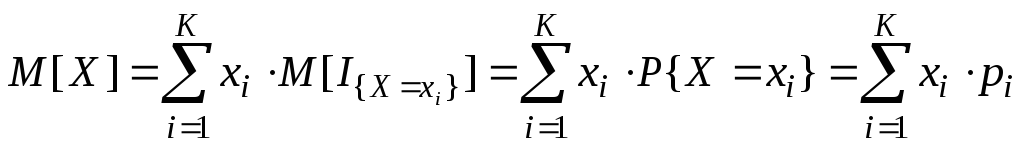

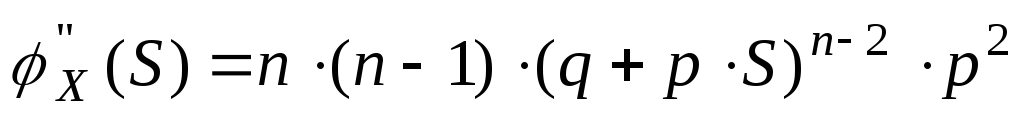

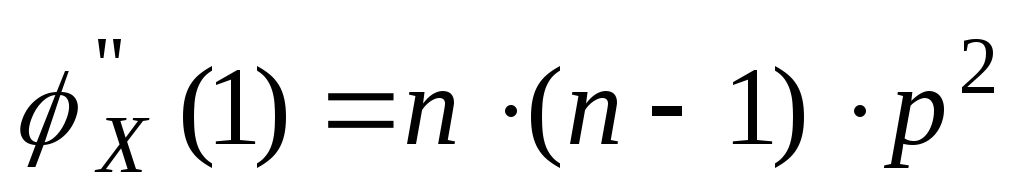

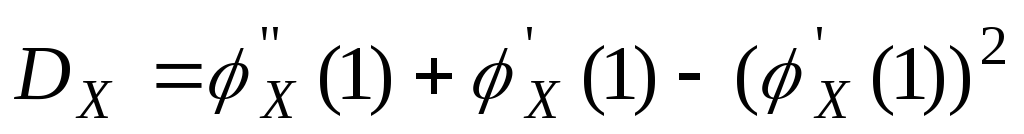

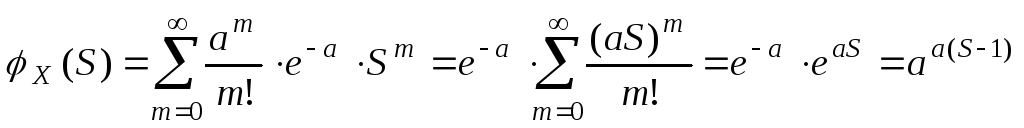

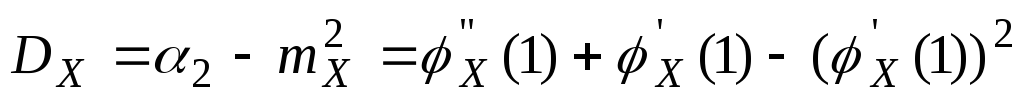

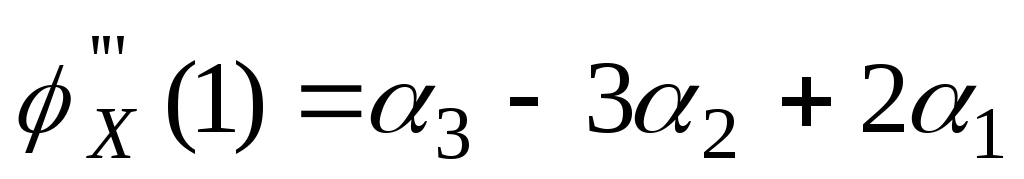

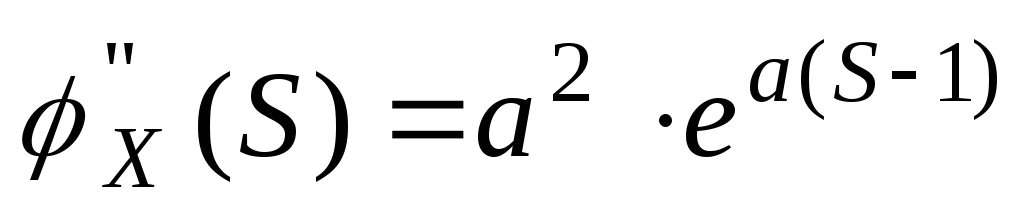

Дисперсия для дискретной сл.вел.:D(x)=M(x2)-M2(x) Математическое ожидание дискретной с.в.: среднее значение случайной величины

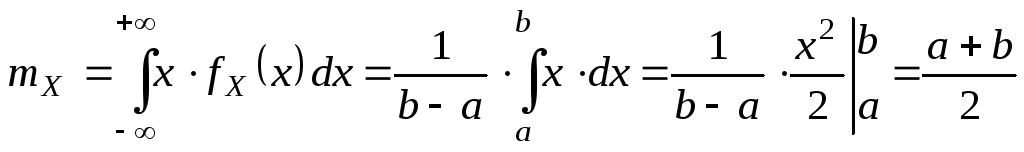

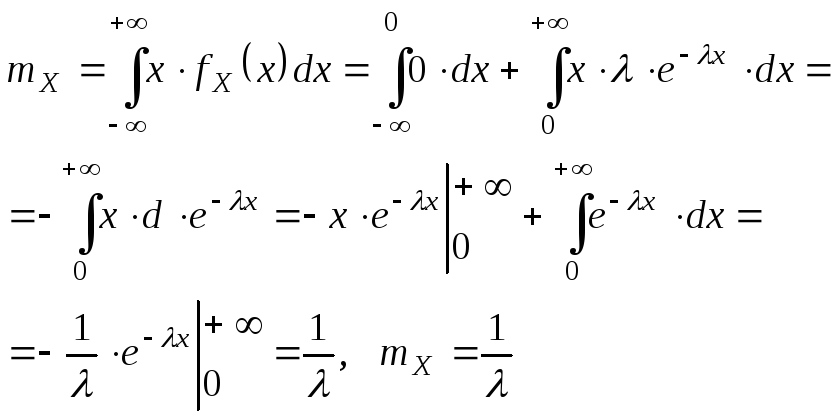

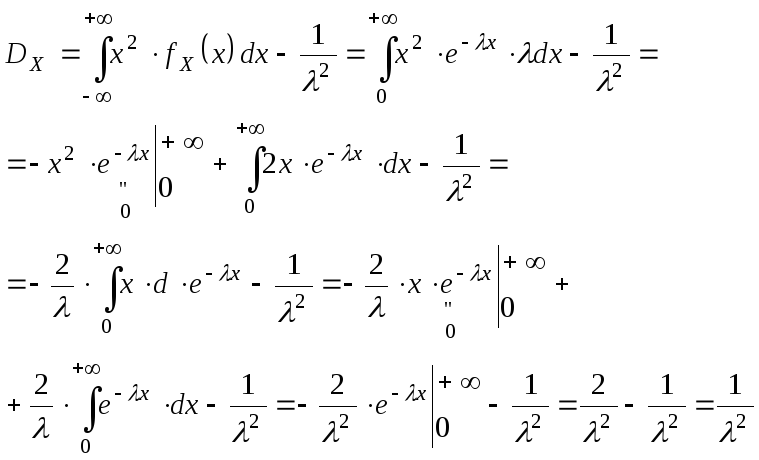

Математическое ожидание непрерывной с.в.:

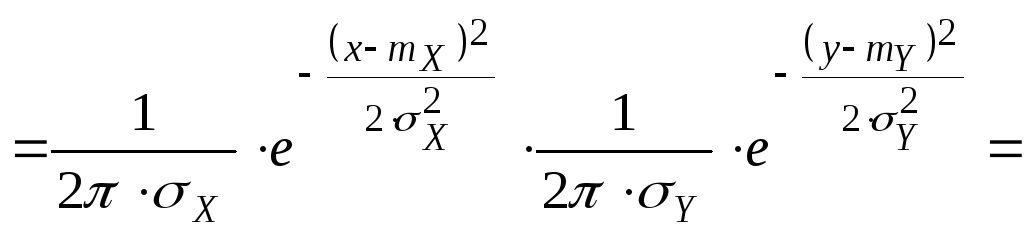

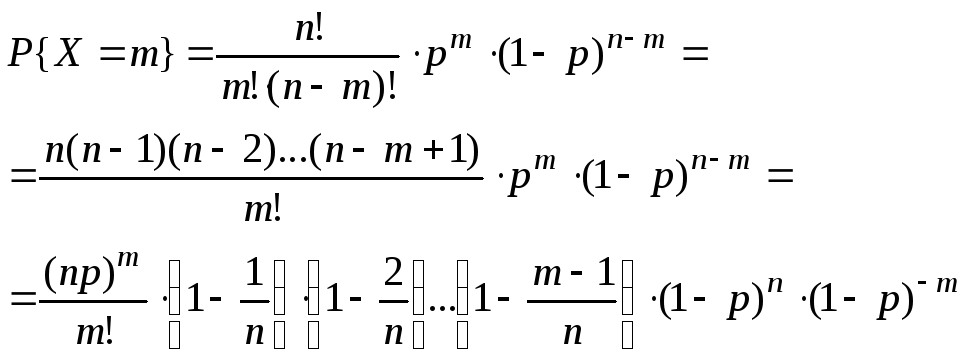

Биномиальное распределение: проводится n испытаний, вероятность появл. соб. А в каждом исп. p. Случайная вел. X-количество появление соб. А в n испытаниях. M(x)=np D(x)=npq Распределение Пуассона: если p мало, a n велико т.е. стремится к бесконечности, то Беном-е распр. переходит в распределение Пуассона. M(x)=a D(x)=a a=np Нормальным называют распределение вероятностей непрерывной случайной величины, которое описывается плотностью: |

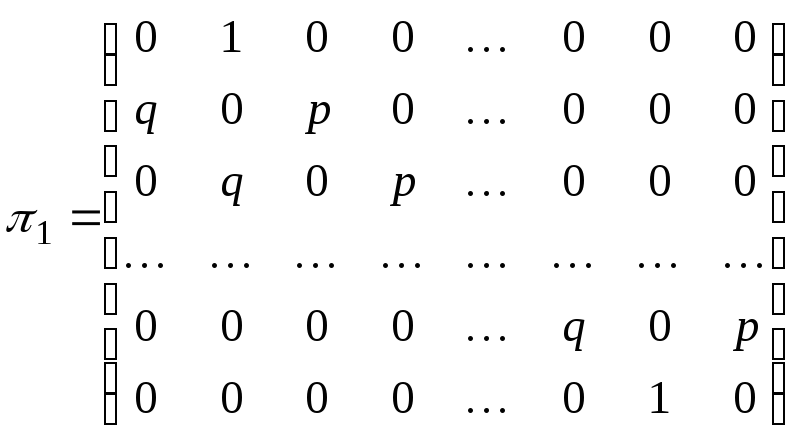

=

|

Теорема сложения несовместных: Теорема сложения совместных: P(A+B)=P(A)+P(B) P(A+B)=P(A)+P(B)-P(AB) Теорема умножения незав.соб. Теорема умножения зав.соб. P(AB)=P(A)*P(B) P(AB)=P(A)*PA(B) P(A)+P( Формула полной вероятности: верть соб.А к-е может наступить лишь при появл. 1 из несовм. соб.(гипотез)= P(A)=P(B1)*PB1(A)+P(B2)*PB2(A)+… Формула Байеса: событие А уже произошло, т.е. известен результат

Формула Бернулли: вероятнось того что в n незав. испыт-х. в каждом из которых вер-ть появ-я события = p , событие наступит ровно k раз = Менее k раз Pn(0)+Pn(1)+Pn(k-1) Более k раз Pn(k+1)+Pn(k+2)+…+Pn(n) или вычитать из единицы вероятность k раз!!! Не менее k раз Pn(k)+Pn(k+1)+…+Pn(n) Не более k раз Pn(0)+Pn(1)+…+Pn(k) Локальная теорема Лапласа: вероятность того что в n испытания в каждом из которых в-ть появления события =p, событие наступит k раз(без учёта последовательности)т.е. после 100 выстрелов, найти в-ть попадения 75 раз. Интегральная теорема Лапласа :в-ть того что в n событиях вер-ть каждого p, событие наступит не менее k1 раз но не более k2 раз.

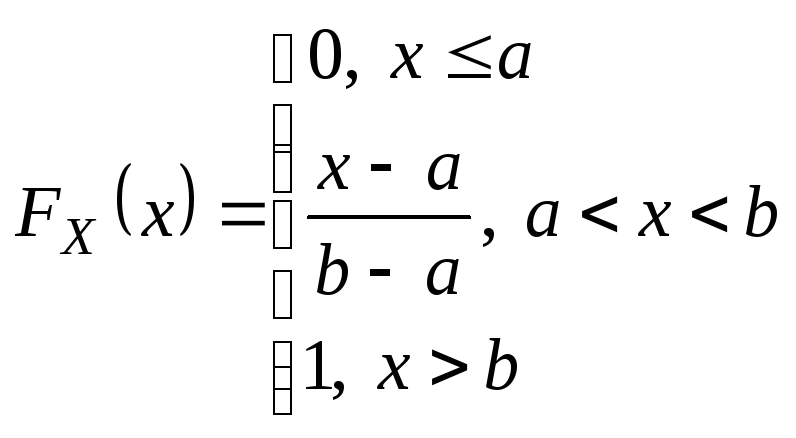

|

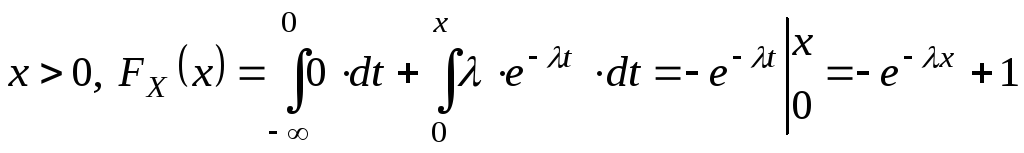

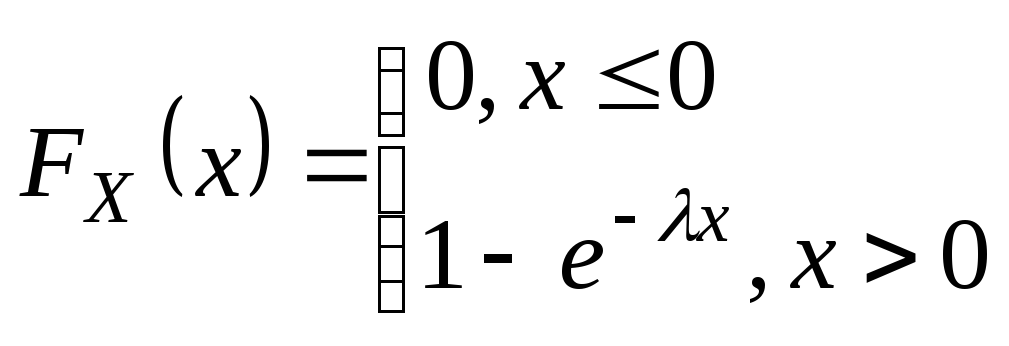

Плотность распределения вероятностей непрерывной случайной величины X называют функцию f(x) – первую производную от функции распределения F(x): Дисперсия через плотность для не прерывной случ.вел.:

Дисперсия для дискретной сл.вел.:D(x)=M(x2)-M2(x) Математическое ожидание дискретной с.в.: среднее значение случайной величины

Математическое ожидание непрерывной с.в.:

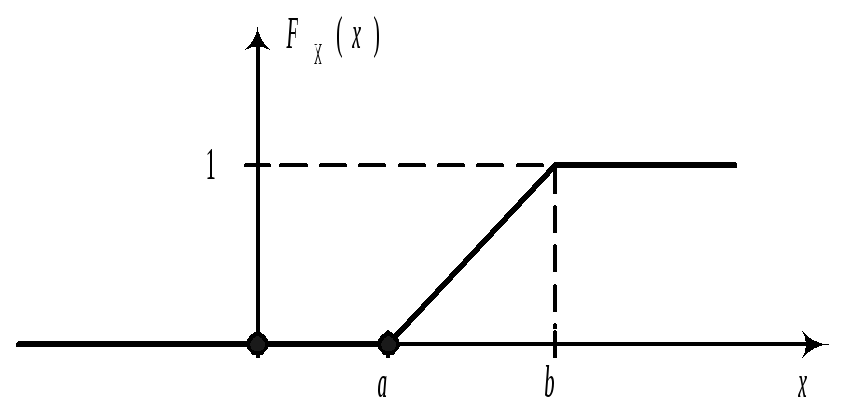

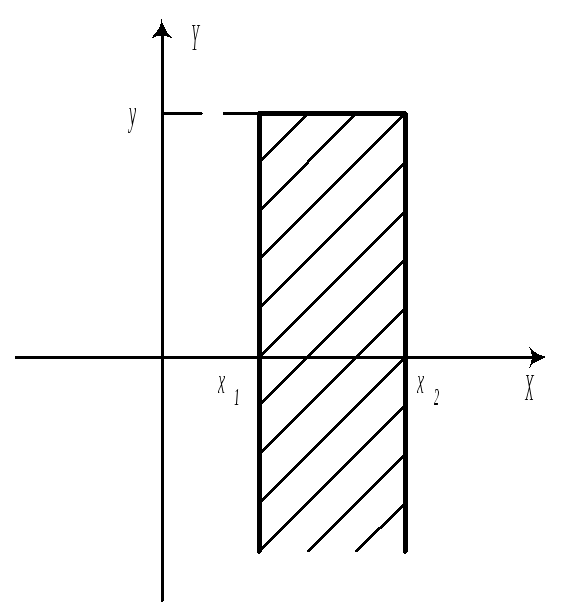

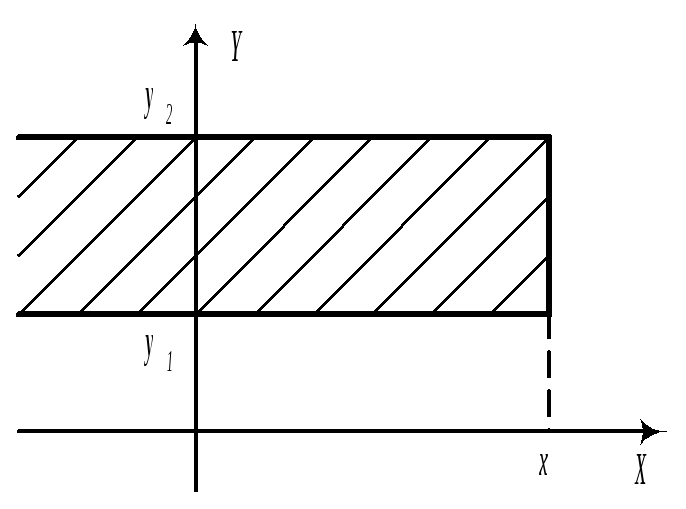

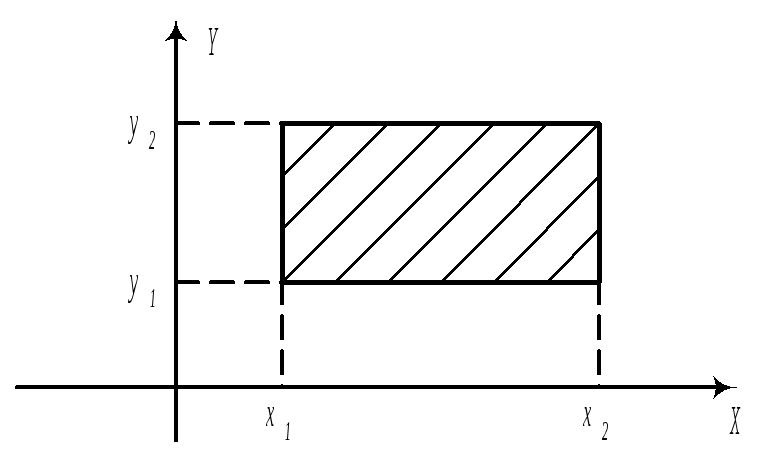

Биномиальное распределение: проводится n испытаний, вероятность появл. соб. А в каждом исп. p. Случайная вел. X-количество появление соб. А в n испытаниях. M(x)=np D(x)=npq Распределение Пуассона: если p мало, a n велико т.е. стремится к бесконечности, то Беном-е распр. переходит в распределение Пуассона. M(x)=a D(x)=a a=np Нормальным называют распределение вероятностей непрерывной случайной величины, которое описывается плотностью: |

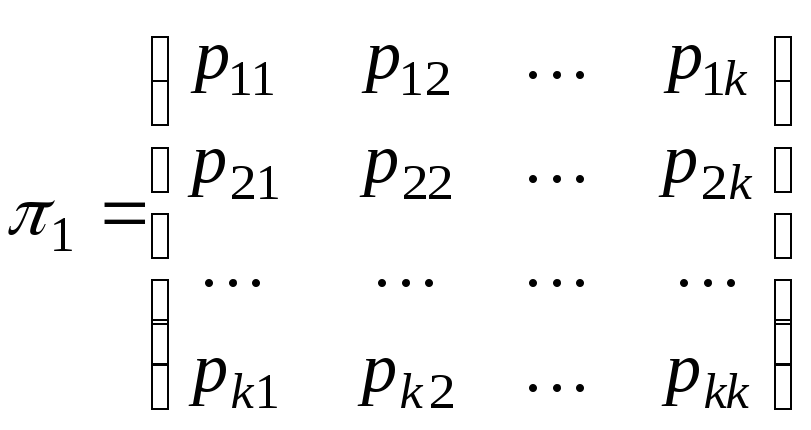

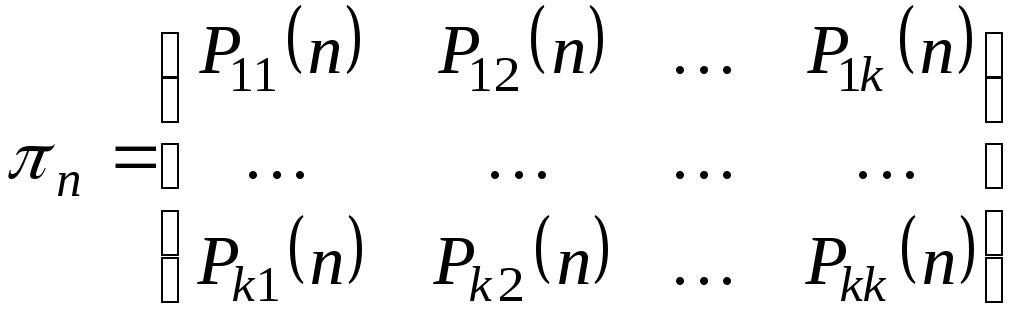

|

Теорема сложения несовместных: Теорема сложения совместных: P(A+B)=P(A)+P(B) P(A+B)=P(A)+P(B)-P(AB) Теорема умножения незав.соб. Теорема умножения зав.соб. P(AB)=P(A)*P(B) P(AB)=P(A)*PA(B) P(A)+P( Формула полной вероятности: верть соб.А к-е может наступить лишь при появл. 1 из несовм. соб.(гипотез)= P(A)=P(B1)*PB1(A)+P(B2)*PB2(A)+… Формула Байеса: событие А уже произошло, т.е. известен результат

Формула Бернулли: вероятнось того что в n незав. испыт-х. в каждом из которых вер-ть появ-я события = p , событие наступит ровно k раз = Менее k раз Pn(0)+Pn(1)+Pn(k-1) Более k раз Pn(k+1)+Pn(k+2)+…+Pn(n) или вычитать из единицы вероятность k раз!!! Не менее k раз Pn(k)+Pn(k+1)+…+Pn(n) Не более k раз Pn(0)+Pn(1)+…+Pn(k) Локальная теорема Лапласа: вероятность того что в n испытания в каждом из которых в-ть появления события =p, событие наступит k раз(без учёта последовательности)т.е. после 100 выстрелов, найти в-ть попадения 75 раз. Интегральная теорема Лапласа: в-ть того что в n событиях вер-ть каждого p, событие наступит не менее k1 раз но не более k2 раз.

|

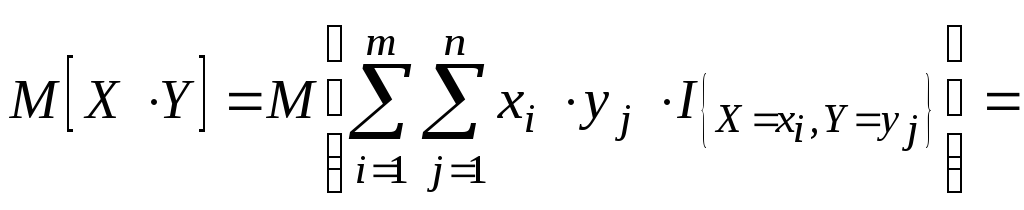

Плотность распределения вероятностей непрерывной случайной величины X называют функцию f(x) – первую производную от функции распределения F(x): Дисперсия через плотность для не прерывной случ.вел.:

Дисперсия для дискретной сл.вел.: D(x)=M(x2)-M2(x) Математическое ожидание дискретной с.в.: среднее значение случайной величины

Математическое ожидание непрерывной с.в.:

Биномиальное распределение:проводится n испытаний, вероятность появл. соб. А в каждом исп. p. Случайная вел. X-количество появление соб. А в n испытаниях. M(x)=np D(x)=npq Распределение Пуассона: если p мало, a n велико т.е. стремится к бесконечности, то Беном-е распр. переходит в распределение Пуассона. M(x)=a D(x)=a a=np Нормальным называют распределение вероятностей непрерывной случайной величины, которое описывается плотностью: |

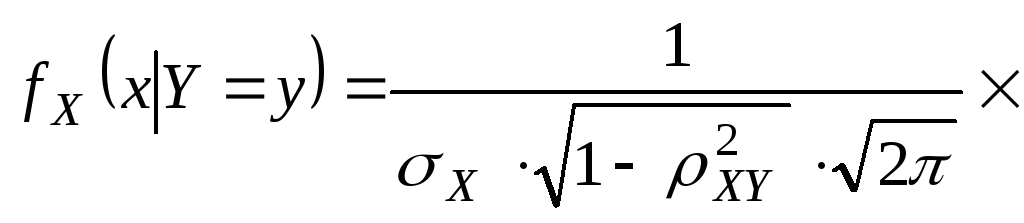

Свежие статьи

Популярно сейчас

Зачем заказывать выполнение своего задания, если оно уже было выполнено много много раз? Его можно просто купить или даже скачать бесплатно на СтудИзбе. Найдите нужный учебный материал у нас!

Ответы на популярные вопросы

То есть уже всё готово?

Да! Наши авторы собирают и выкладывают те работы, которые сдаются в Вашем учебном заведении ежегодно и уже проверены преподавателями.

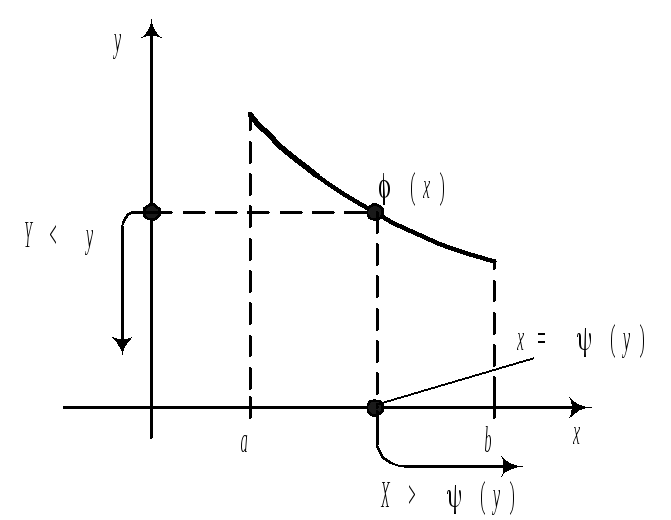

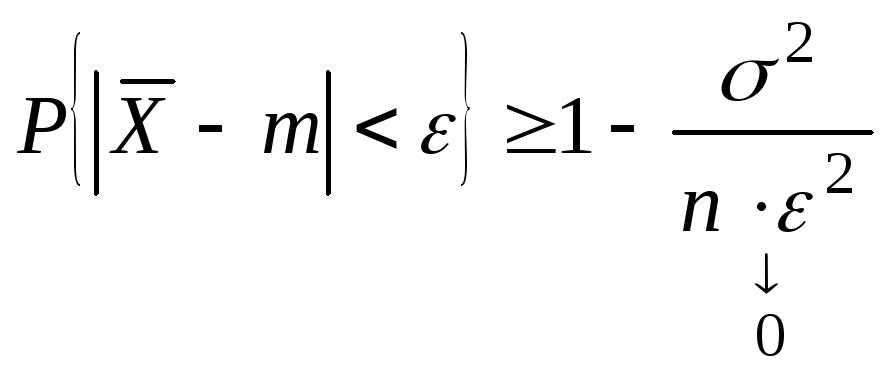

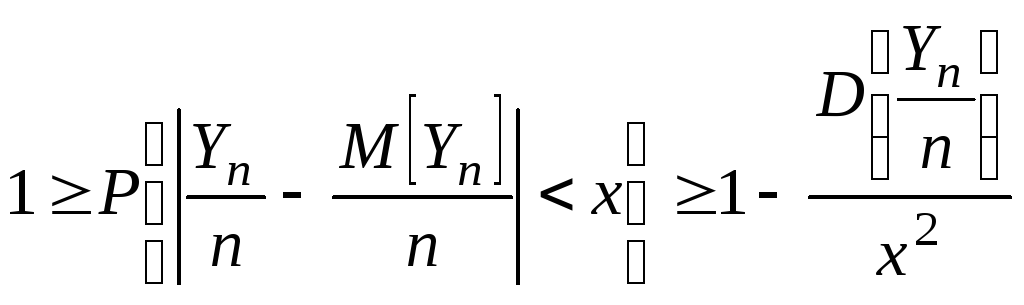

А я могу что-то выложить?

Да! У нас любой человек может выложить любую учебную работу и зарабатывать на её продажах! Но каждый учебный материал публикуется только после тщательной проверки администрацией.

А если в купленном файле ошибка?

Вернём деньги! А если быть более точными, то автору даётся немного времени на исправление, а если не исправит или выйдет время, то вернём деньги в полном объёме!

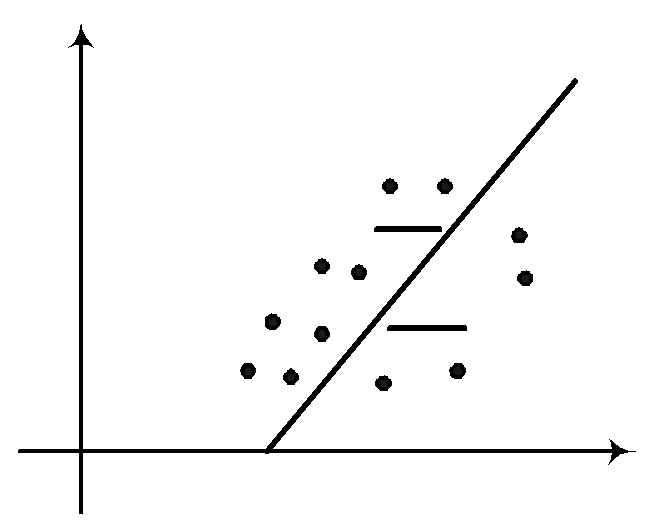

Отзывы студентов

Добавляйте материалы

и зарабатывайте!

Продажи идут автоматически

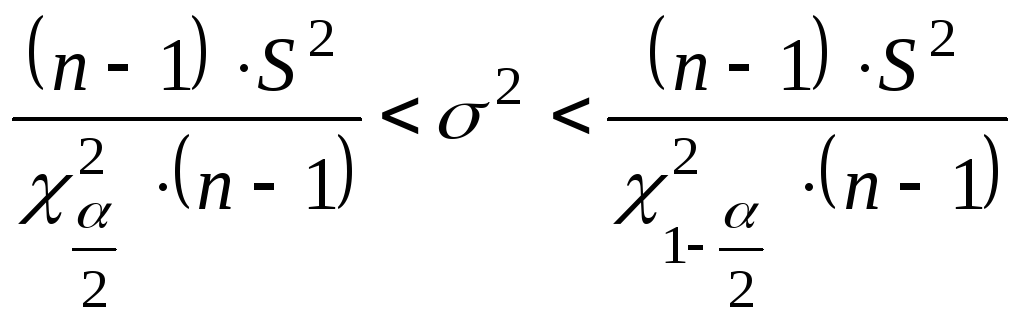

650

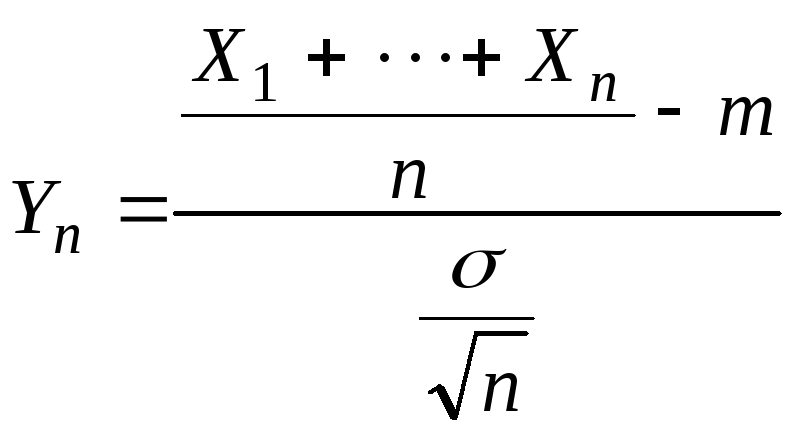

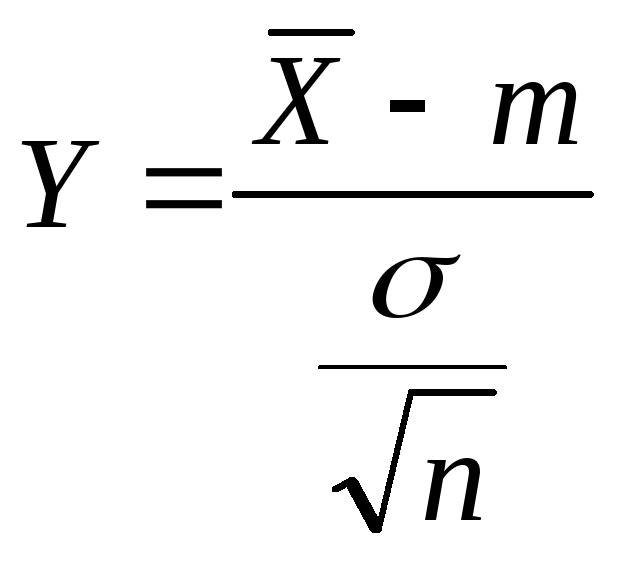

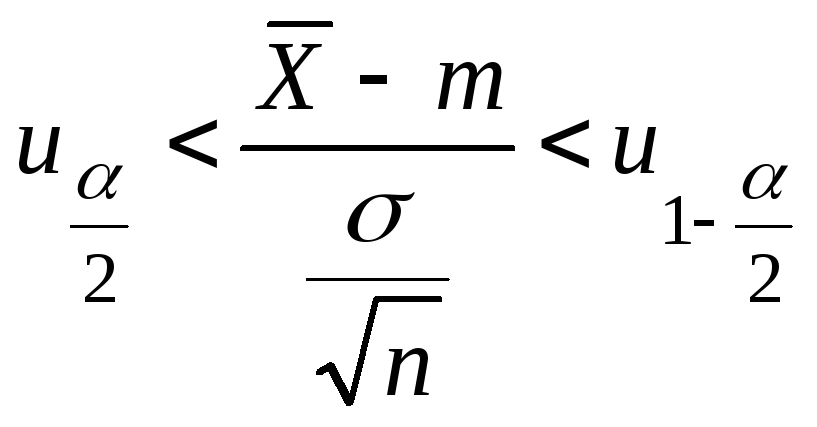

Средний доход

с одного платного файла

Обучение Подробнее

1.Предмет

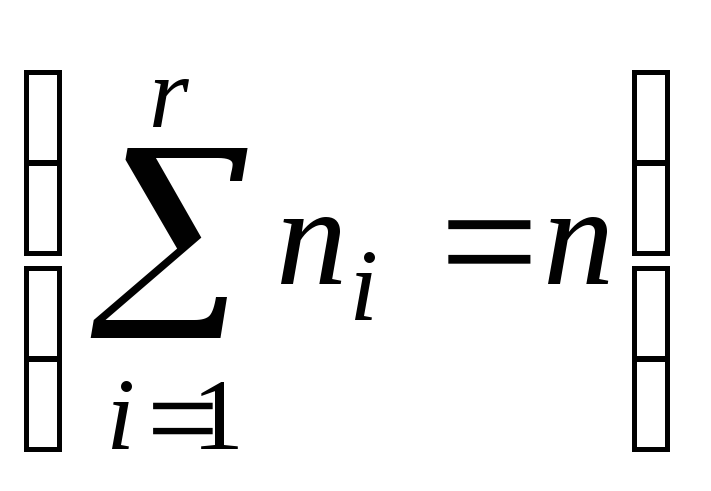

теории вероятностей.События.Алгебра

событий.Теория

вероятностей–раздел

математики, изучающий закономерности

случайных явлений.Разница между

закономерными и случайными

событиями.Закономерное

событие–это

событие, которое всегда осуществляется,

как только создаются определённые

условия.Закономерное

явление –

это система закономерных событий.Случайные

события–это

события, которые при одних и тех же

условиях иногда происходят, а иногда

нет.Однако случайные события подчиняются

некоторым закономерностям, которые

называются вероятностными

закономерностями, при этом надо

условится, что мы будем иметь дело не

со всякими случайными событиями, а с

массовыми,

то есть будем предполагать, что в

принципе можно создать много раз одни

и те же условия, при каждом из которых

могут произойти или нет некоторые

случайные события.Пусть при осуществлении

некоторых условий (N

раз), случайное событие A,

будет осуществляться N(А)

раз.Число N(А)

– называется частотой событий A,

а отношение

– относительной частотой события

А.Если

N

велико, относительная частота для

случайных массовых событий обладает

свойством устойчивости.Пример:–серия

испытаний.–

относительная частота испытаний.

…

Относительная

частота колеблется около определенного

числа, которое характеризует данное

случайное событие.Р(А)

– вероятность события А.

Примеры:1)Пусть

случайное событие A

– выпадение герба при одном подбрасывании

симметричной однородной монеты,Р(А)

= 1/2 – вероятность выпадения

герба.2)Статистика рождений показывает,

что мальчиков рождается несколько

больше, чем девочек. Доля рождения

мальчиков 0,51-0,52.Р(А)

= 0,51; 0,51 – вероятность рождения

мальчиков.

События.

Достоверное

событие

– событие, которое всегда происходит

(Ω).Невозможное

событие –

событие, которое не происходит никогда

().Событие

Ā

– событие противоположное событию

A.

Ā

происходит тогда и только тогда, когда

не происходит событие A.Суммой

событий A

и B

называется событие A+B,

которое происходит тогда и только

тогда, когда происходит или A,

или B,

или оба вместе.

Произведением

событий A

и B

называется событие AB,

которое происходит тогда и только

тогда, когда происходят A

и B

вместе.Разностью

событий A

и B

называется событие A—B,

которое происходит тогда и только

тогда, когда происходит A

и не происходит B.События

A

и B

несовместны,

если AB=.Событие

A

влечет за собой событие B,

если из наступления события A

следует наступление события B

(A

B).События

A

и B

называются равносильными

A=B,

если выполняются одновременно два

включения A=B

A

B

и B

A.Пример:

Бросается игральная кость. A

= {выпадает четное число очков} и B

= {выпало

число очков, не большее трех}Решение:

Выпало число очков отличное от 5

(A+B).Выпало

2 (AB).Выпало

число очков равное 4 или 6 (A—B).Выпадает

нечетное число очков (Ā).

3.Конечное

вероятностное пространство. Классическое

определение вероятности. Рассмотрим

случай конечного вероятностного

пространства. В этом случае

состоит из конечного числа элементарных

событий .

= {}

A

– алгебра всех подмножеств

(ввиду конечности вероятностного

пространства алгебра автоматически

является -алгеброй),

тогда вероятность P(A)

для любого подмножества A

задаем следующим образом. Пусть заданы

неотрицательные числа P,

которые удовлетворяют следующему

требованию

,

тогда вероятность события

(*) (способ введения вероятности на

конечном вероятностном

пространстве).Очевидно, что так

определенная вероятность вместе

P()=0

будет удовлетворять всем аксиомам.

Обозначим через -

– количество элементов в множестве

A.

Частным случаем определения вероятности

по формуле (*) будет так называемое

классическое определение вероятностей,

когда все P

будут равны друг другу, так как;

;

–

формула классической вероятности

(**)

Замечание:Модель

вероятностного пространства, приводящая

к классическому определению

вероятностей, когда элементарные

события обладают свойствами «симметрии».

Пример:Бросается кубик на стол. 1

= {выпадает 1} 2

= {выпадает 2} – свойства симметрии

9.Формула

полной вероятности

Система

событий A1,…,An

называется

конечным разбиением(разбиением)

пространства ,

если они:

1)попарно

несовместны, т.е. AiAj=,

если i

j.

2)

A1+A2

+… An

=.

Теорема

(Формула полной вероятности)

Если

A1,…,An

–

разбиение

и все P(Ai)>0,

то для всех событий B

.

Доказательство:B=B=B(A1+…+An)=BA1+…+BAn

Пример.

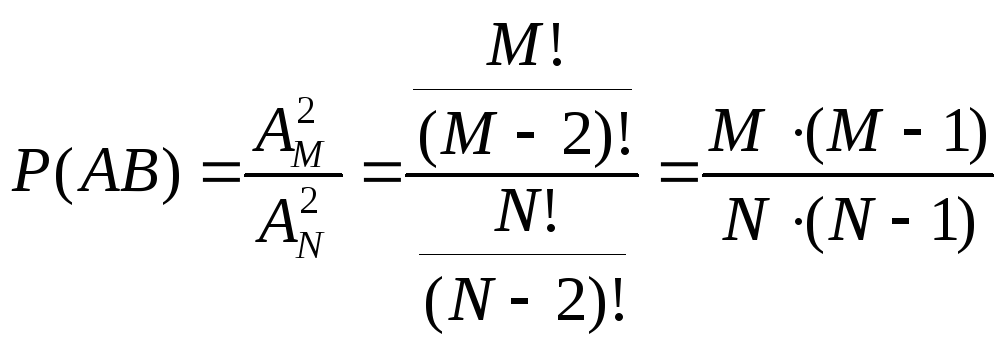

В урне находятся M-белых

шаров и N—M-черных

шаров. По схеме выборки без возвращения,

последовательно выбираются два шара.

Найти вероятность события B={второй

вынутый шар белый}. A

= {первый шар белый}. Ā={ первый шар

черный}

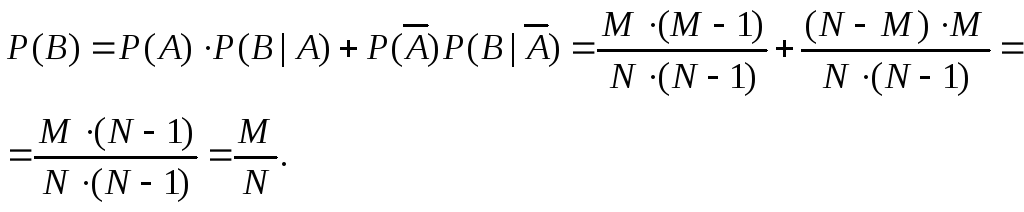

Решение

A

Ā =

, A

+

Ā

=

Пример

показывает, что при правильно

организованной жеребьевке шансы

будут равны.

8.Условные

вероятности; теорема умножения

N

– число испытаний;

A,

B,

AB

– события;

N(A),

N(B),

N(AB)

– частоты

событий;

–

условная

относительная частота события A

при условии, что произошло событие

B;

;

;

Если

все относительные частоты событий

устойчивы, тогда условная относительная

частота тоже устойчива. Пусть

P(B)>0.Условной

вероятностью

P(A|B)

события A

при условии, что событие B

произошло, называется отношение

.

P(A|B)

= PB(A)

(встречается в литературе).

Теорема

умножения

Если P(A)>0,

P(B)>0,

а P(A|B),

то вероятность произведения

.

Доказательство:

Доказательство

следует из определения.

Пример:

1 способ. В урне

находятся M-белых

шаров и N—M-черных

шаров. По схеме выборки без возвращения,

последовательно выбираются два шара.

Найти вероятность того, что оба шара

будут белыми.

A

= {1 вынутый шар белый} B

= {2 вынутый

шар белый} AB

= {оба шара белых}

,

.

2 способ.

Следствие.

Пусть события

A1,…,An

таковы,

что

P(A1…An-1

)>0 тогда.

Доказательство:

Доказательство проводится методом

математической индукции.

13.Функция

распределения случайной величины.

Её свойства. Функция распределения

СВДТ. Ряд

распределения может быть построен

только для СВДТ, для недискретных

случайных величин из-за несчетности

множества возможных значений такое

представление невозможно. Наиболее

общей формой закона распределения

пригодной для всех

типов

случайных величин является функция

распределения. Функция F(x)=Fx(x)=P{X<x},

xR

называется функцией

распределения

СВ Х.

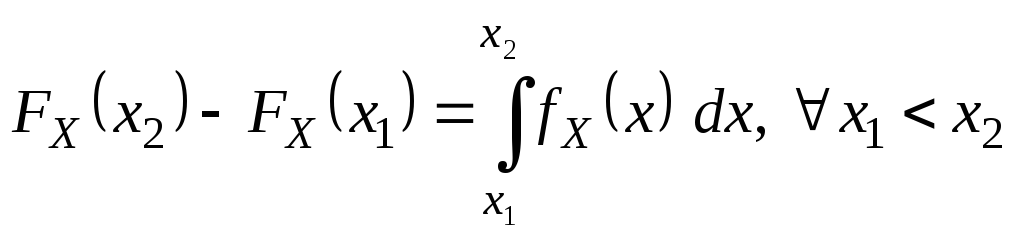

С помощью функции распределения можно

выразить вероятности попадания CB Х

в различные интервалы вида x1X<

x2

, x1X

x2

, x1<X

x2

, x1<X<

x2

. Пусть x1

< x2

, тогда {X<

x2}

разложим в сумму двух несовместных

событий {X<x2}={X<

x1}+{

x1

X<x2},

тогда P{X<x2}=P({X<

x1}

+{ x1

X<x2})=P{X<

x1}+

P{

x1

X<x2};

FX(x2)=FX(x1)+

P{

x1Xx2};P{

x1Xx2}=

FX(x2)-FX(x1)

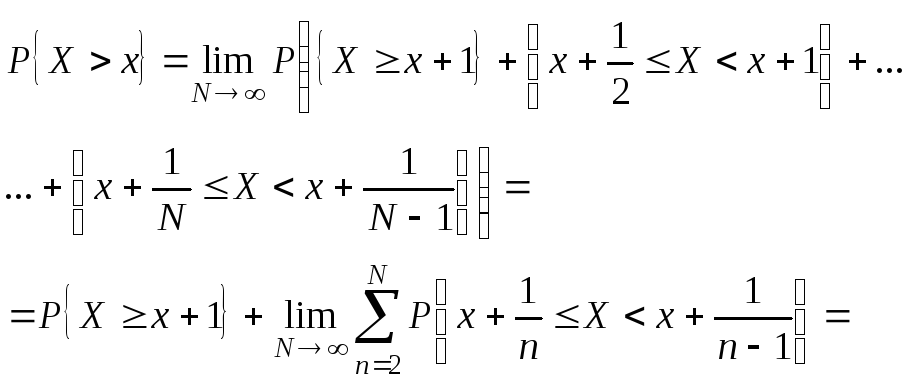

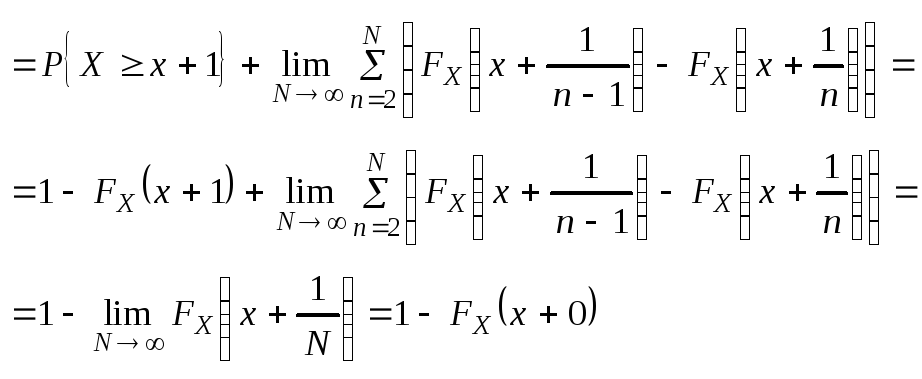

(**) Событие {X>x}

можно представить, как счетную сумму

несовместных событий

Согласно (**).

P{X>x}=1-

FX(x+0);

P{Xx}=1-

P{X>x}=FX(x+0);

P{x1Xx2}=FX(x2+0)-

FX(x1);

P{

x1Xx2}=FX(x2+0)-

FX(x1+0);P{

x1Xx2}=FX(x2)-

FX(x1+0);

P{

X=x}=FX(x+0)-

FX(x);

Теорема.

Функция

FX(x)

обладает следующими свойствами:

1.

FX(x)

– не убывает;

2.

FX(x)

– непрерывна слева;

3.

FX(+)=1;

4.

FX(-)=0;.

Доказательство

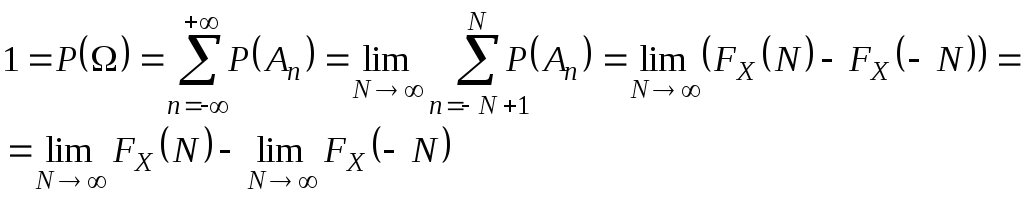

3 и 4:

1.Следует

из (**), т.к. P{x1Xx2

}0.

2.Следует

из аксиомы непрерывности 4,

т.к. события

FX(x)=

FX(x-0)

.

Свойства

3, 4 вытекают из аксиомы счетной

аддитивности (3*), т.к. =ΣAn

(-<n<),

где

An={

n-1X()<n},

тогда

Пусть

(по теореме Вейeрштрасса).

(0

FX(N)

1 )

Из

равенства P{X=x}=FX(x+0)-FX(x)

следует, что в точках разрыва функции

FX(x)

имеет место положительная вероятность.

P{X=x}>0

Так

как при каждом натуральном n

может быть не более n-точек

x

с вероятностями P{X=x}1/n,

то у функции FX(x)

имеется не более счетного числа точек

разрыва.Обозначим через x1,x2,..

все точки разрыва функции FX(x),

если вероятности P{X=x}=Pk

таковы, что Σpk=1,

то это равносильно тому, что СВ X

имеет дискретное распределение, то

есть является СВДТ.Замечание.

Для СВДТ

FX(x)

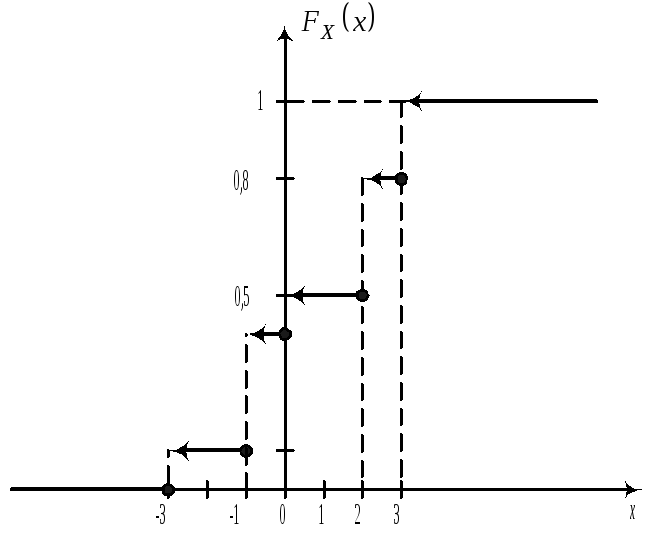

имеет ступенчатый вид. Пример.

X

-3 -1 0 2 3

P

0,1 0,3 0,1 0,3 0,2

Получить

функцию распределения и построить

ее график. Решение. FX(x)=P{X<x},

т.е. FX(x)=0(x-3);

FX(x)=0,1(-3<x-1);

FX(x)=0,4(-1<x0);

FX(x)=0,5(0<x2);

FX(x)=0,8(2<x3);

FX(x)=1(x>3);

P{X=2}=

FX(2+0)-

FX(2)=0,8-0,5=0,3;

P{-1<X2}=FX(2+0)-FX(-1+0)=0,8-0,4=0,4

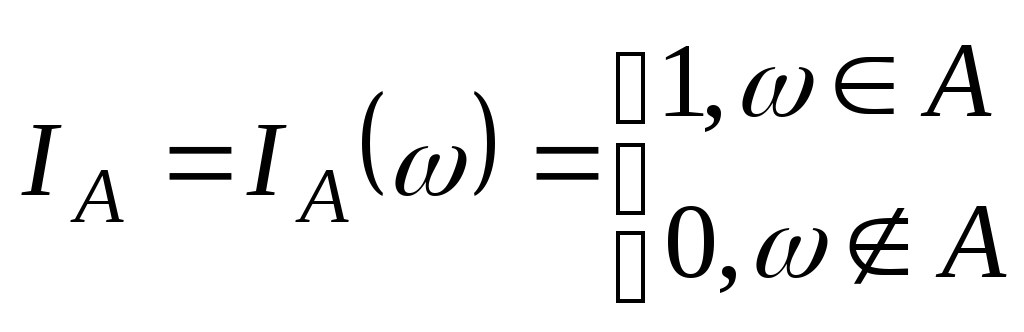

Введем

новое важное понятие индикатора

события.

Опр:Индикатором

события A

A

называется

СВ :

.

Ряд

распределения случайной величины IA

имеет следующий вид

|

IA |

0 |

1 |

|

P |

1–p |

p |

где

р-вероятность

события А.

16.Моменты

n-го порядка. Дисперсия. Среднее

квадратическое отклонение.

МО в теории

вероятностей относится к типу

характеристик положения (см. далее

мода, медиана), кроме них используется

еще ряд числовых характеристик

различного назначения, среди них

особое значение имеют моменты

(начальные, центральные).Положим

g(x)=xS.

Опр.Начальным

моментом S-го

порядка СВ Х

называется S=M[XS].

Замечание:

Иногда

используются абсолютные начальные

моменты S-го

порядка M[XS].

Для СВДТ:

Для СВНТ:

.

Замечание.

– начальный

момент 1-го

порядка.

Обозначим

.

Определение.

Центральным моментом S-го

порядка называется

.

Замечание.

Иногда используются

абсолютные центральные моменты S-го

порядка.

.

Для СВДТ:

.

Для СВНТ:

.

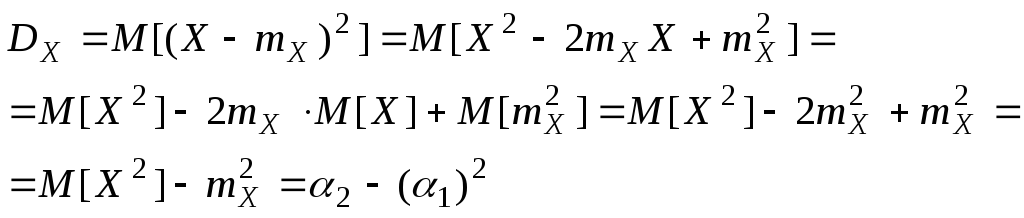

Определение.

Центральный момент II-го

порядка ()

называется дисперсией

СВ Х

и обозначается

.

Для СВДТ:

.

Для СВНТ:

.

Опр.

– называется средним квадратическим

отклонением СВ Х

(стандартным отклонением в литературе).

Свойства

дисперсии:

1.

.

Доказательство:

.

2.

.

Доказательство:

.

(*).

По свойству 4 МО

и с учетом неравенства (*) получаем

доказательство свойства 2 для дисперсии.

3.

.

Доказательство:

Пример.

Пусть на прямой

в точках x1

<x2

<…<xk

расположены

точечные массы p1,p2.,

pk

Σpi=1:

M[X]=Σxipi

(1<i<k)

– центр тяжести

D[X]=

Σ(xi-mi)pi

(1<i<k)

– момент

инерции масс pi

относительно центра тяжести.

Таким образом,

МО характеризует место, вокруг которого

группируются массы pi,

а дисперсия – степень разбросанности

этих масс относительно МО.

21. Простейший

Пуассоновский поток

На

практике часто встречаются ситуации,

где имеет место распределение Пуассона.

Задача.

Пусть

на оси времени 0t

случайным образом возникают точки

моменты появления каких-то однородных

событий. (Например, вызовы на телефонной

станции, приход посетителей в магазин

и т.д.)). Последовательность таких

моментов назовем потоком

событий.Предположим, что поток обладает

следующими свойствами.

Свойства.

1)Стационарность.Это

свойство означает, что вероятность

попадания, того или иного числа

событий, на участок времени длиной

не зависит от того, где на оси 0t

расположен этот участок, а зависит

только от его длины .Из

этого следует, что среднее число

событий, появляющееся в единицу ()

времени , постоянно.

– интенсивность потока.

2)Ординарность.Это

свойство заключается в том, что

вероятность попадания на малый участок

t

двух или более событий пренебрежимо

мала с вероятностью попадания на него

одного события.

Т.е.

при t0

вероятность двух или более событий

является бесконечно малой более

высокого порядка малости, чем

вероятность попадания на него одного

события.

3)Отсутствие

последствия.Это

свойство означает, что вероятность

попадания некоторого числа событий

на заданный участок оси 0t

не зависит от того сколько событий

попало на любой другой не пересекающийся

с ним участок (в частности “будущее”

потока не зависит от его “прошлого”).

Опр.Поток

событий, обладающий этими 3-мя свойствами

называется простейшим

(или стационарным) Пуассоновским

потоком.

Покажем, как

простейший Пуассоновский поток связан

с распределением Пуассона.

СВ

Х

– количество событий, попадающих на

участок 0t,

длиной .

Покажем, что Х

имеет распределение Пуассона.

Доказательство:

Разделим

участок длины

на n

равных частей

t

=/n.

МО числа событий, попадающих на

элементарный участок t,

равно t*.

Согласно свойству 2 (ординарности)

можно пренебречь вероятностью

попадания на элементарный участок

t,

двух или более событий. Назовем

элементарный участок t

– занятым, если на нем появилось

событие из потока. Назовем элементарный

участок t

– свободным, если на нем не появилось

событие из потока.A

= {участок t

занят} IA=

1(участок t

занят) IA=

0 (участок t

свободен).

M[IA]=pt–

вероятность того, что участок t

занят. Среднее число, то есть МО числа

событий, попадающих на участок длины

t,

будет равно M[IA]=

t*.

pt=

t*.

pt=*/n

Рассмотрим

теперь n-участков

на временной оси, как n-независимых

испытаний (опытов), в каждом из которых

(независимость этих испытаний

из свойства 3) может появиться событие

А

и вероятность этого события

.

Число занятых элементарных участков

– это и есть Х.

СВ

Х

имеет биномиальное распределение

.

Будем

теперь неограниченно увеличивать

число элементарных участков и найдем

при

.

Согласно

теореме Пуассона, при

,

28.Оценка

отклонения теоретического распределения

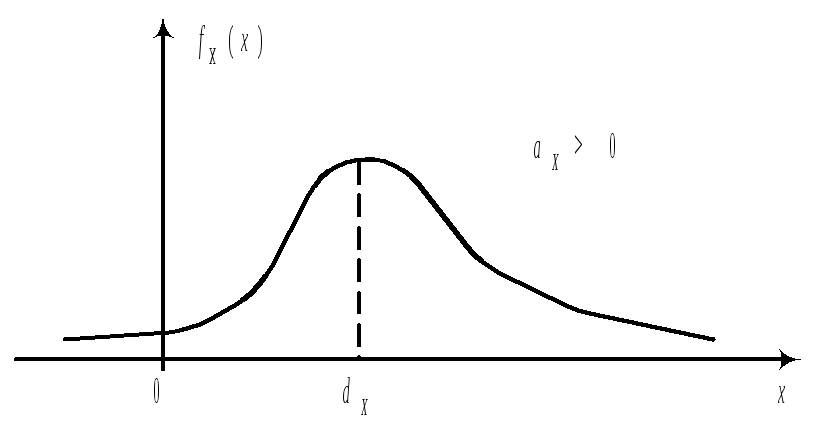

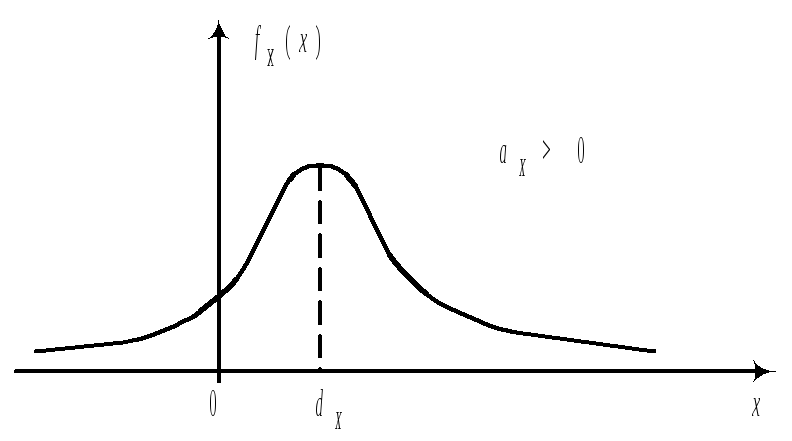

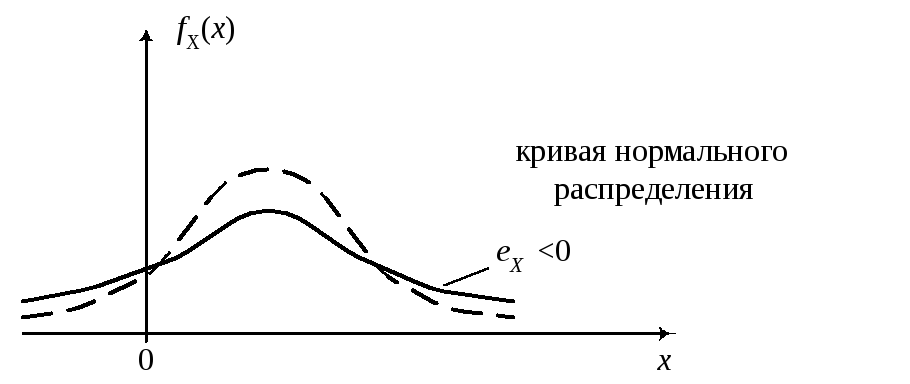

от нормального; асимметрия и эксцесс.

При

изучении распределений, отличных от

нормального, возникает необходимость

количественно оценить это различие.

С этой целью вводят специальные

характеристики (асимметрию и эксцесс).

Для

нормального распределения эти

характеристики равны 0, поэтому, если

для изучаемого теоретического

распределения асимметрия и эксцесс

имеют небольшие значения, то можно

предположить близость этого

распределения к нормальному. Наоборот

большие значения

aX

и eX,

указывают значительные отклонения

от нормального.

Пологая

часть правее моды, значит aX>0.

Пологая

часть левее моды, значит aX<0.

Замечание.При

исследовании эксцесса надо считать,

что нормальное исследуемое распределение,

имеют одинаковое МО и дисперсию.

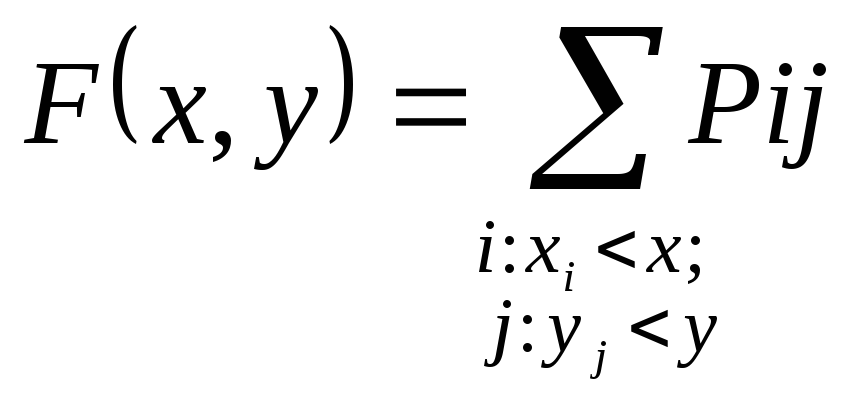

30.Дискретные

двумерные случайные величины

Опр.

Двумерная

СВ (X,

Y)

называется дискретной, если каждая

из СВ и Х

и Y

является

дискретной.

Пусть

СВ Х

может принимать значения

,

а СВ Y

принимает дискретные значения

.

|

Y X |

y1 |

y2 |

… |

ym |

P{X=xi} |

|

x1 |

P11 |

P12 |

… |

P1m |

P1 |

|

x2 |

P21 |

P22 |

… |

P2m |

P2 |

|

… |

… |

… |

… |

… |

… |

|

xn |

Pn1 |

Pn2 |

… |

Pnm |

Pn |

|

P{Y=yj} |

P1 |

P2 |

… |

Pm |

|

Двумерный

случайные вектор может принимать

только пары значений

По этой таблице

нетрудно определить функцию

распределения.

.

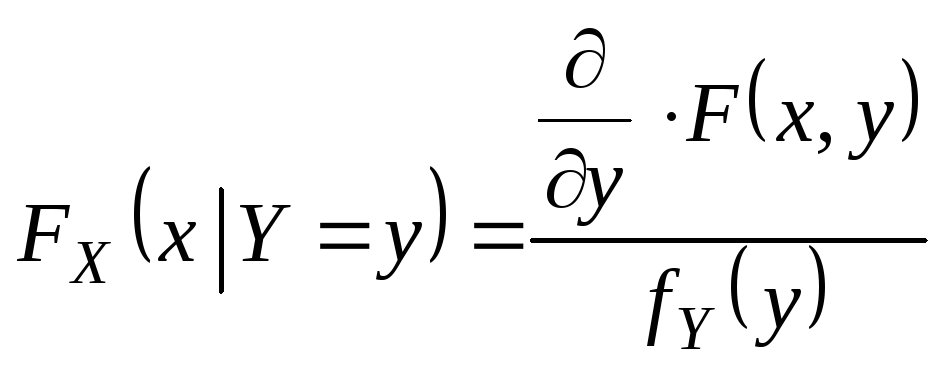

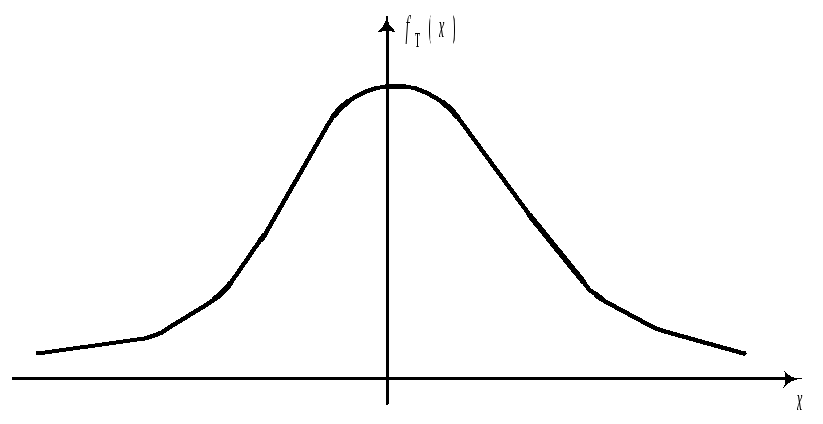

33.Условные

законы распределения для системы СВ.

Если СВ

образующие систему зависимы, то для

нахождения закона распределения

системы не достаточно знать законы

распределения отдельных величин,

входящих в систему, требуется знать

так называемый условный закон

распределения одной из них.

ОпрУсловным

законом распределения одной из величин

системы (X,

Y)

называется ее закон распределения

вычисленный при условии, что другая

СВ приняла определенное значение.

Начнем

с наиболее простого случая, а именно

со случая, когда СВ Y

является дискретной.

Опр.Условной

функцией распределения

называется условная вероятность

события

Замечание

1.Условная

функция распределения обладает всеми

свойствами, которые присущи обычной

(т.е. безусловной) функции распределения.

Замечание

2Если

СВ X

также дискретная, причем

,

то удобно рассматривать условную

вероятность

,

СВ X

принять значения

при условии, что

,

В

общем случае условную функцию

распределения

,

однако, это не всегда возможно. Потому,

что для непрерывного типа P{Y=y}=0.

Чтобы отстроиться от этих неприятностей,

попытаемся воспользоваться предельным

переходом, заменяя событие {Y=y},

событием {yY<y+}

и устремив

0.

Получим.

Назовем

условной функцией распределения

Оказывается

такой предел всегда существует.Если

СВ Y

– непрерывна, то условную функцию

распределения можно определить

следующим выражением

В

наиболее важных для приложений случаях

вектор (X,

Y)

представляет собой двумерную

непрерывную СВ с совместной плотностью

.

Так

как функция

имеет производную по x,

то мы получаем окончательное выражение

для условной плотности.

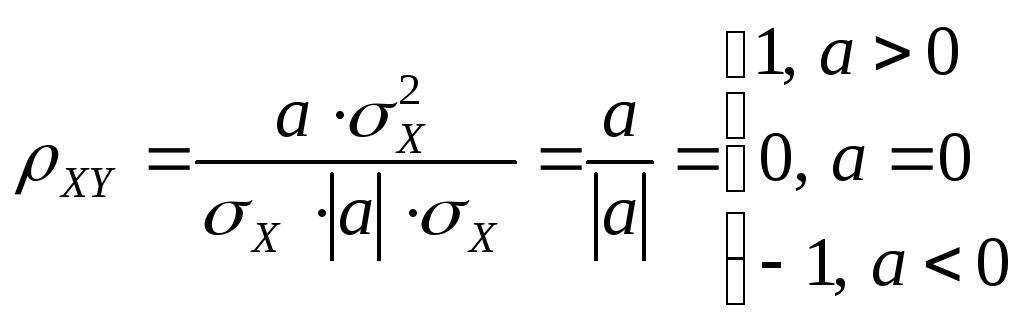

36.

Коэффициент корреляции. Связь между…

Опр.

Величина XY

называется коэффициентом корреляции

СВ X

и Y.

Коэффициент

XY

характеризует степень зависимости

СВ X

и Y,

но не любой, а только линейной

зависимости, которая проявляется в

том, что при возрастании одной СВ X

, другая также проявляет тенденцию

возрастания, в этом случае XY>0.

Если одна возрастает, а другая убывает,

то XY<0.

В первом

случае говорят, что две СВ связаны

положительной корреляцией. Во втором

случае говорят, что две СВ связаны

отрицательной корреляцией. Модуль

XY

характеризует степень тесноты линейной

зависимости между СВ X

и Y.

Если линейной зависимости нет, то

XY=0.

Теорема

Если же СВ

X

и Y

связывает жесткая функциональная

линейная зависимость Y=aX+b,

то XY=1

при a>0,

XY=

–1 при

a<0.

Доказательство:

;

Теорема:

XY1

Доказательство:

Рассмотрим СВ

,

тогда

;

;

;

.

Опр.

СВ X

и Y

называется

не коррелированными, если XY

=0 (или KXY=0).

Замечание.Из

независимости СВ следует их не

коррелированность. Обратное не верно.

Из коррелированности не вытекает их

независимость

Теорема.

D[X+Y]

= DX+DY+2

KXY

Доказательство:

D[X+Y]=M[((X+Y)–(mX

–

mY))2]=

M[((X– mX)+(Y

–

mY))2]=

M[(X–

mX)2+

2(X– mX)(

Y

–

mY)+

(Y

–

mY)2]=

DX+DY+2

M[(X–

mX)(Y

– mY)]=

DX+DY+2

KXY

Следствие:

(доказательство

проводится методом математической

индукции).

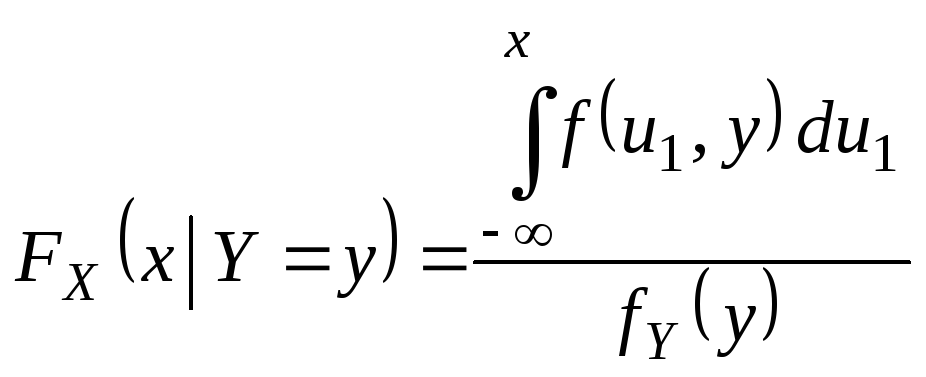

40.Функции

от многомерных СВ. Формула

композиции.Функция

от многомерной СВ определяется точно

также, как и функция от одномерной

СВ. Мы рассмотрим это понятие на

примере двумерной СВ. Пусть на

вероятностном пространстве (,

A,

P),

задана двумерная СВ (X,

Y).

Предположим, что у нас имеется

измеренная числовая функция g(X,Y)

числовых аргументов X

и Y.

СВ Z=g(X,Y)

= g(X(),Y())

, назовем функцией от двумерной СВ

(X,

Y).

а)

Функция g(X,Y)от

двумерной дискретной

СВ (X,

Y)

снова является дискретной СВ,

принимающей значения g(xi

,

yj)

с вероятностями Pij=P{X=xi

,Y=yj

}

Чтобы построить ряд распределения

СВ Z=g(X,Y)

надо:1) Исключить все те значения g(xi

,

yj)

, вероятность которых равна нулю; 2)

Объединить в один столбец все одинаковые

значения g(xi

,

yj),

приписав этому столбцу суммарную

вероятность.

б)

В случае когда СВ (X,

Y)

непрерывного типа с плотностью f(x,y),

функция распределения Z=g(X,Y)

будет определяться формулой

Область

интегрирования здесь состоит из всех

точек (x,

y)

для которых g(X,Y)<Z.

особо важным для практики представляется

случай, когда X

и Y

– независимые

СВ, а функция Z=X

+ Y,

тогда g(x,y)=x+y.

Получается так называемая формула

композиции:

fX(x)

— ф-я плотности композиции от х

fY(y)

— ф-я плотности композиции от у

f(x,y)=

fX

(x)

fY

(y)

Интеграл (*)

вычисляется, как повторный, поэтому

.

Дифференцируя

по z

получаем

– формулы

композиции (свертки).

С помощью этих

формул легко выражаются формулы

плотности и функции распределения

суммы независимых СВ.

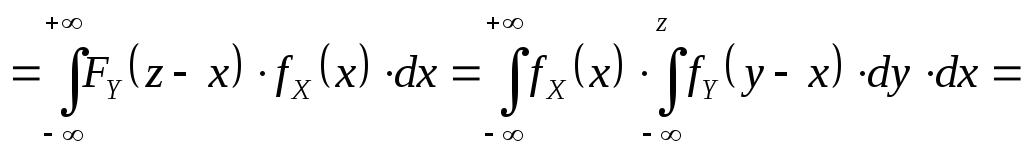

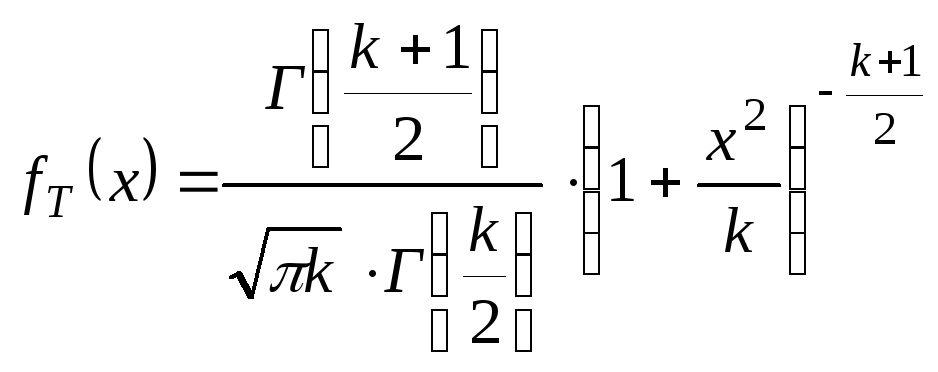

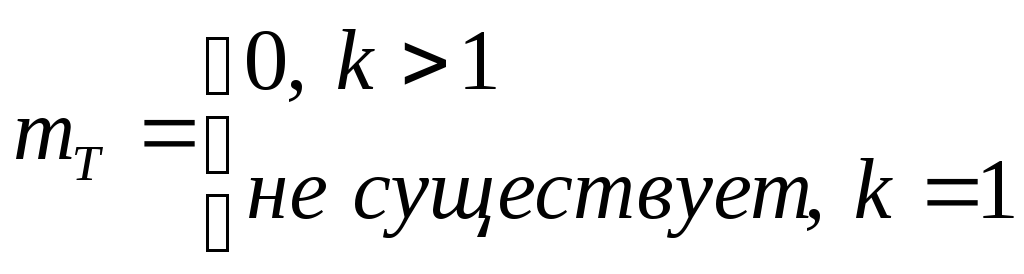

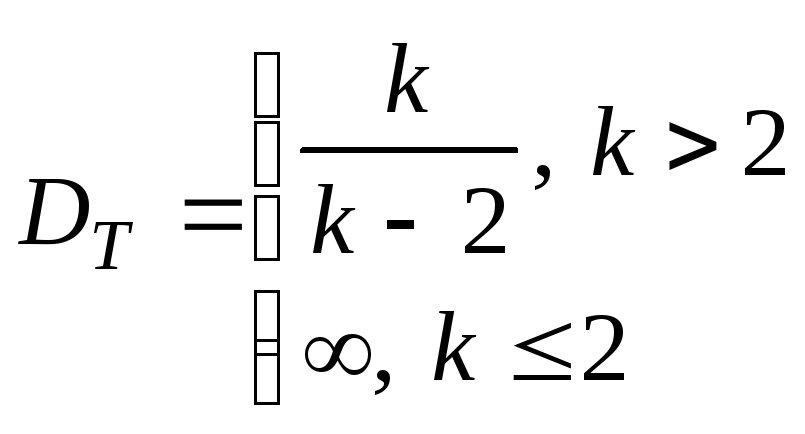

42.Распределение

Стьюдента.Пусть

Z~N(0;1).

V–

независимая от Z

СВ, которая распределена по закону

2

с k

степенями свободы.

Рассмотрим

СВ

СВ

Т

имеет распределение, которое называется

t–распределением

или распределением Стьюдента с k

степенями свободы.

t–распределение

определяется одним параметром –

числом степеней свободы.

С

возрастанием числа степеней свободы

t–распределение

асимптотически (довольно быстро)

приближается к стандартному нормальному

распределению с параметрами (0; 1).

Для

СВ, имеющих распределение Стьюдента,

имеется таблица квантилей, причем в

силу четности

.

46.Выборка

и способы ее представления Задачи

математической статистики: Установления

закономерностей, которым подчинены

массовые случайные явления основано

на изучении методами теории вероятностей

статистических данных (результатов

наблюдений)1.

Задача математической статистики :

Указать

способы сбора и группировки

статистических сведений, полученных

в результате наблюдений или в результате

специально составленных экспериментов.2.

Задача математической статистики:

1) Разработать

методы анализа статистических данных

в зависимости от целей исследования:

а)

оценка неизвестной вероятности

событий; б)

оценка неизвестной функции распределения;

в)

оценка параметров распределения, вид

которого известен; г)

оценка

зависимости СВ от одной или нескольких

других СВ. 2) Проверка статистических

гипотез о виде неизвестного распределения

или о величине параметров распределения

вид, которого известен.

Современную

математическую статистику определяют

как науку о принятии решений в условиях

неопределенности.

Выборка

и способы ее представления: Математическая

статистика позволяет получить

обоснованные выводы о параметрах,

видах распределений и других свойствах

СВ о конечной совокупности наблюдений

над этими величинами.

Выборка

понимается следующим образом. Пусть

СВ Х

наблюдается на каком либо эксперименте,

повторим этот эксперимент n

раз при одинаковых

условиях. Получаем Х1,..,

Хn

где каждая Хj

– СВ соответствующая j-му

эксперименту. Очевидно, что Хj

– независимые в совокупности СВ,

причем каждая из этих СВ имеет один

и тот же закон распределения, что и

СВ Х.

Опр.

Закон

распределения СВ Х

называется распределением генеральной

совокупности.

СВ

вектор Х1,..,

Хn

называется выборочным вектором, а

конкретные числа x1,..,

xn,

получаемые на практике при n

кратном повторении эксперимента в

неизменных условиях представляет

собой реализацию выборочного вектора

и называются выборкой объема n.

Что такое

вариационный ряд, размах выборки,

статистический ряд, группированный

статистический ряд, частоты,

относительные частоты, накопленные

частоты, относительные накопленные

частоты, всевозможные полигоны и

гистограммы, а также, что такое

эмпирическая функция распределения

изучили самостоятельно.

47.Числовые

характеристики выборки Пусть

x1,..,

xn

выборка объема n

из генеральной совокупности с функцией

распределения FX(x).

Рассмотрим выборочное

распределение,

т.е. распределение дискретной СВ,

принимающей эти значения с вероятностями,

равными 1/n.

Соответственно числовые характеристики

этого выборочного распределения

называют выборочными (эмпирическими)

числовыми характеристиками. Замечание.

Выборочные

числовые характеристики являются

характеристиками данной выборки, но

не являются характеристиками

распределения генеральной совокупности.

“~” – при обозначении этих числовых

характеристик.

.

.

– унимодального, т.е. одновершинного

распределения называется элемент

выборки, встречающийся с наибольшей

частотой. Выборочной медианой

называется

,

которое делит вариационный ряд на

две части, содержащие равное число

элементов. Если n

– нечетное число, т.е. n

= 2l+1,

то

.

Если n

– четное число, т.е. n

= 2l,

то

.

Можно доказать, что выборочные

начальные

и центральные

моменты порядка s

для негруппированных выборок объема

и определяются по следующим формулам

;

.

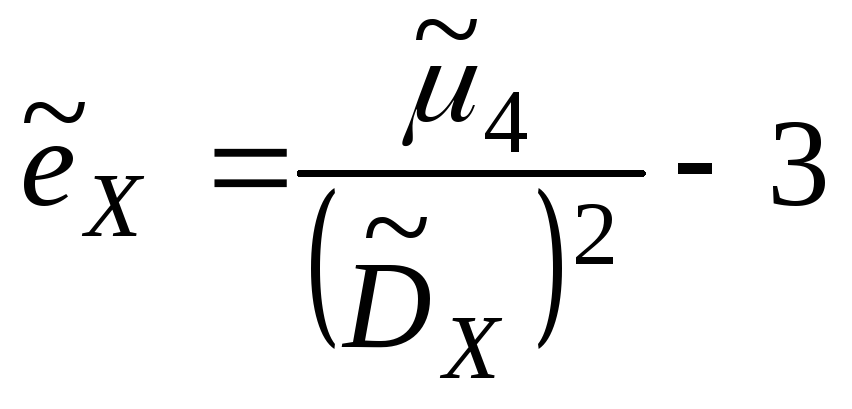

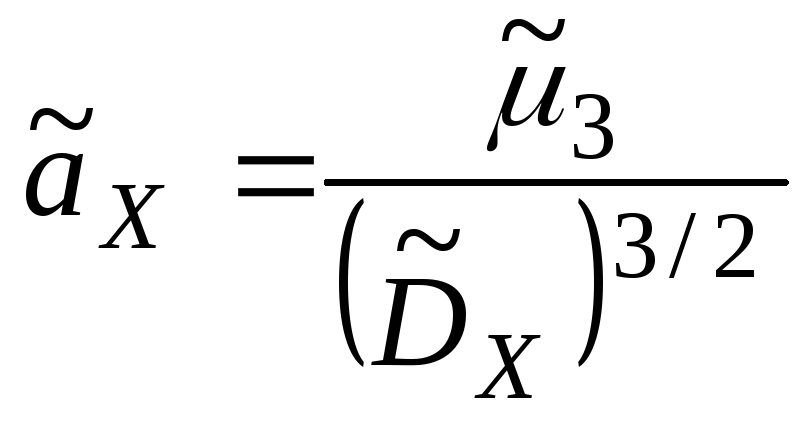

Форма распределения СВ характеризуется

выборочными коэффициентами асимметрии

и эксцесса.

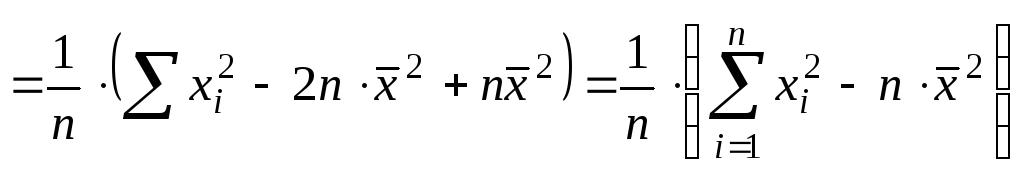

51. Выборочная

дисперсия

Докажем, что

выборочная дисперсия является

смещенной оценкой для дисперсии

генеральной совокупности.

Выполним следующие

преобразования

;

.

Найдем МО для

дисперсии:

.

.

МО не совпадает

с 2,

а отличается на –2/n

– смещение. Таким образом эта оценка

занимает в среднем истинное значение

дисперсии на величину 2/n,

правда это смещение сходит на нет при

n

.

Чтобы устранить

это смещение надо «исправить»

дисперсию.

;

;

.

Можно доказать,

что статистика S2

является и состоятельной оценкой для

дисперсии генеральной совокупности.Замечание.

К сожалению, на практике при оценке

параметров не всегда оказывается

возможным одновременное выполнение

требований: несмещенности, эффективности

и состоятельности.

54. Доверительный

интервал для оценки МО при НЕизвестной

дисперсии

2)Доверительный

интервал для оценки МО при неизвестной

дисперсии нормально распределенной

генеральной совокупности. Пусть

– выборочный вектор n–наблюдений

СВ

.

В качестве оценки для m

возьмем

.

Если дисперсия генеральной совокупности

неизвестна, то по выборке определяем

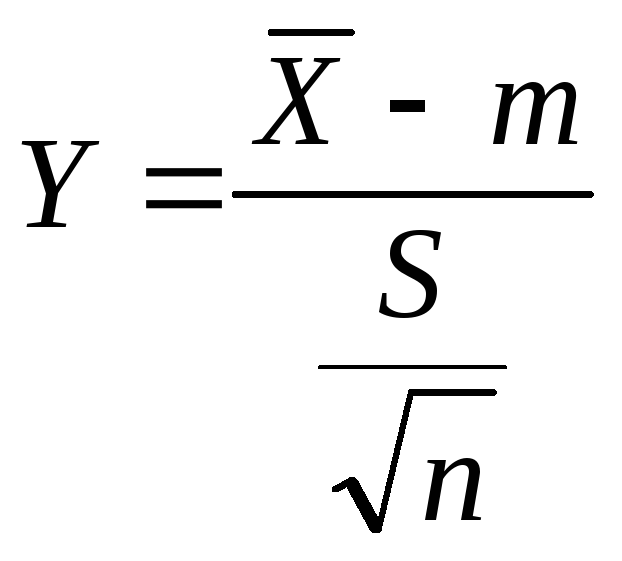

статистику

.

Доверительный интервал для m

в этом случае находится с помощью

статистики

В

литературе по статистике показано,

что Y

имеет распределение Стьюдента с n–1

степенью свободы

.

По

заданной доверительной вероятности

,

используя таблицы распределения

Стьюдента с n–1

степенью свободы, находим

.

.

.

56.

Проверка статистических гипотез

Пусть

Х

– наблюдаемая СВ. Она может быть

дискретной, а может и непрерывной.

Опр.

Статистической

гипотезой Н называется предположение

относительно параметров или вида

распределения СВ Х. Гипотеза Н

называется простой, если она однозначно

определяет распределение СВ Х,

иначе Н называется сложной.

Если распределение

СВ Х известно и по выборке наблюдений

необходимо проверить предположение

о значении параметров этого

распределения, то такие гипотезы

называются параметрическими. А

гипотезы о виде распределения –

непараметрические.

Проверяемая

гипотеза называется нулевой гипотезой

и обозначается Н0.

Обязательно на ряду с Н0

рассматривают одну из альтернативных

гипотез Н1.

При

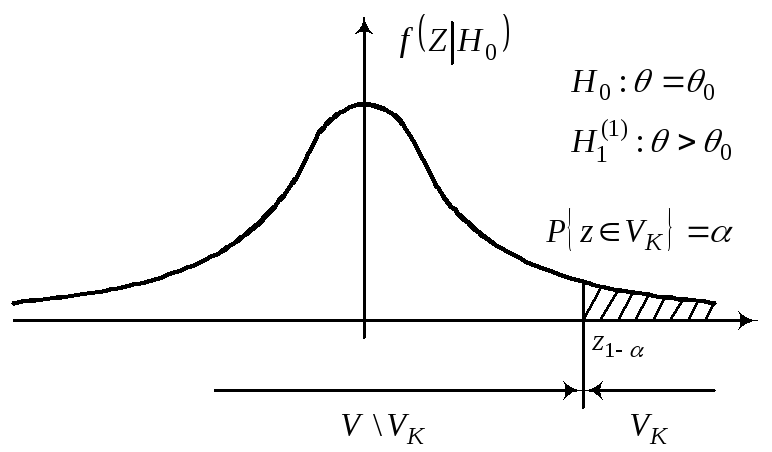

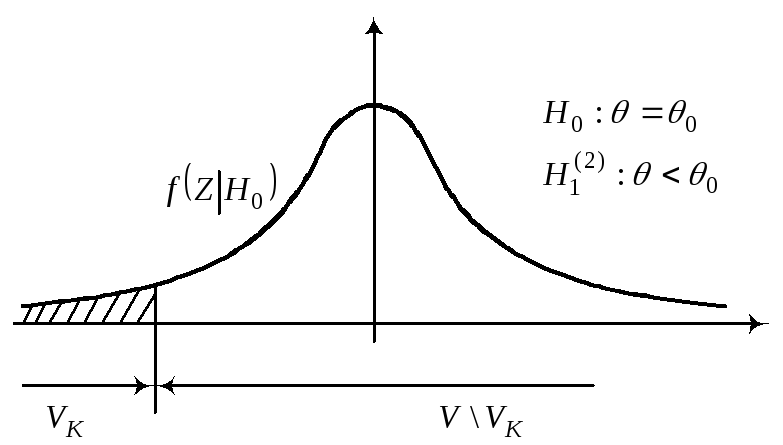

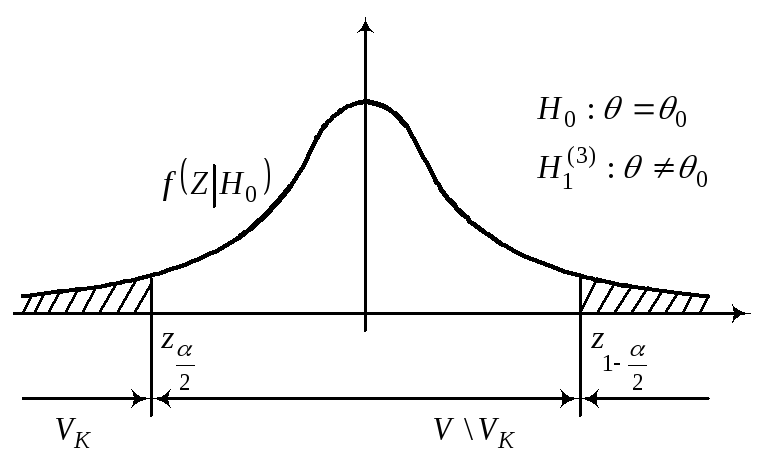

этом имеются различные ситуации для

Н1.

;

;

;

.

Выбор

альтернативной гипотезы Н1

определяется конкретной формулировкой

задачи.

Опр.Правило,

по которому принимается решение

принять или отклонить гипотезу Н0,

называется критерием К.

Так как решение принимается на основе

выборки наблюдений СВ Х,

то необходимо выбрать подходящую

статистику, которую мы будем называть

статистикой Z

критерия К.Замечание.

При проверке

простой параметрической гипотезы

Н0:

=0

в качестве статистики критерия

выбирают ту же статистику, что и для

оценки параметра ,

т.е..Основной

принцип при проверке статистической

гипотезы:

Маловероятные события считаются

невозможными, а события, имеющие

большую вероятность, считаются

достоверными. Реализация этого

принципа на практике. Перед анализом

выборки фиксируется некоторая малая

вероятность ,

называемая уровнем значимости. Пусть

V

множества значений статистики Z,

VK

– подмножество множества значений

статистики Z

(VK

V).

Это такое подмножество, что при условии

истинности гипотезы Н0,

имеем вероятность того, что P{ZVkH0}=.

Обозначим через zв

– выборочное значение статистики Z,

которое вычитается по конкретной

выборке. Критерии К

формулируется следующим образом.

Отклонить

гипотезу Н0,

если zвVk.

Отклонить гипотезу Н0,

если zвV

Vk.

Уровень значимости

определяет размер критической области,

а ее положение зависит от альтернативной

гипотезы Н1.

Z1––квантиль

распределения Z

при условии, что верна гипотеза Н0.

Z–

квантиль распределения Z

при условии, что верна гипотеза Н0.

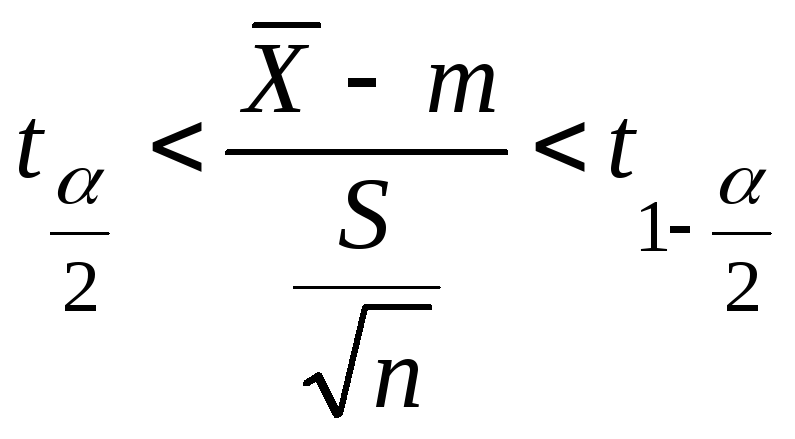

Проверку

параметрической гипотезы при помощи

критерия значимости можно разбить

на следующие этапы:1)сформулировать

Н0

и Н1;2)назначить

;3)выбрать

статистику Z

для проверки Н0;4)определить

выборочное распределение Z

при условии, что верна Н0;5)определить

VK

(она зависит от Н1);6)получить

выборку и вычислить zb

;7)принять статистическое решение:

zвVk

– отклонить Н0;

zвV

Vk

– принять Н0.

Статистическое решение может быть

ошибочным. При этом различают ошибки

I-го

и II-го

родов.Опр.

Ошибкой первого рода называется

ошибка, состоящая в том, что гипотеза

Н0

отклоняется, когда Н0

– верна. Вероятность P{ZVkH0}=..ОпрОшибкой

второго рода называется ошибка,

состоящая в том, что принимается

гипотеза Н0,

но в действительности верна

альтернативная гипотеза Н1.

Вероятность ошибки второго рода при

условии, что гипотеза Н1

– простая, P{ZVVkH1}=.Проверка

статистических гипотез и доверительных

интервалов.Проверка гипотез с

использованием критерия значимости

может быть проведена на основе

доверительных интервалов. При этом

одностороннему критерию значимости

будет соответствовать односторонний

доверительный интервал, а двустороннему

критерию значимости будет соответствовать,

двусторонний доверительный интервал.

Гипотеза Н0

– принимается, если значение 0

накрывается доверительным интервалом,

иначе отклоняется.

2.Вероятностное

пространство.Вероятность,ее

свойства.Теорема сложения.Тройка

(,

A,

P),

где

– это пространство элементарных

событий;A

– -алгебра

подмножеств ,

называемых событиями;P

– числовая

функция, определенная на событиях и

называемая вероятностью.P

называется вероятностным

пространством,

если выполнены следующие аксиомы:1)P(A)

0,AA.2)P()

= 1 (нормированность P).3)P(A+B)=P(A)

+ P(B),

если AB=

(аддитивность).4)Для любой убывающей

последовательности A1

A2

…

An…событий

из A

такой, что,

Имеет место равенство

(непрерывность

P).Замечания:

Аксиомы

3, 4 можно заменить одной аксиомой

-адди-тивности:

3*. Если события An

в последовательности A1,

A2,

… попарно

несовместны,

то

Из этих аксиом

вытекают Свойства

вероятностей:

1)Если

A

B,

то вероятность P(B–A)

= P(B)

– P(A).

Доказательство:

Разобьем событие

B

в сумму несовместных событий

B=A+(B-A),

A(B-A)=,

P(B)

= P(A+(B-A))=P(A)+P(B-A)

(по

аксиоме

3)

P(B—A)=P(B)

— P(A)

.

2)Если

A

B,

то P(A)

P(B)Доказательство:

Доказательство

следует из 1 свойства и аксиомы 1.

P(A)

+ P(B—A)

= P(B)

P(B—A)

0, следовательно

P(A)

P(B)

.

3)A

A

0

P(A)

1 Доказательство:

A

P(A)

P(),

P()

= 1(по

аксиоме

2)

P(A)

0, A

A(по

аксиоме

1) .

4)P(Ā)

= 1 — P(A)

Доказательство: A+

Ā =

,

A

Ā =

Тогда по аксиоме

3 и аксиоме 2 получаем

P(A+

Ā)

= P(),

P(A)

+ P(Ā)

= P(),

P(A)

+P(Ā)

=

1

P(Ā)

= 1 — P(A)

.

5) P()

= 0Доказательство:

+

=

Тогда по аксиоме 3 и 2 получаем, P()

+ P()

= P()

P()

+ 1 = 1, P()

= 0 .

6)Теорема

сложения

A,

B

A

: P(A+B)

= P(A)

+ P(B)

– P(AB)

Доказательство:

A

+ B

= A

+ (B

— AB),

A(B

— AB)

=

P(A+B)

= P(A)

+ P(B

— AB),

но AB

B

следовательно по первому свойству

(вероятность от разности равна разности

вероятностей).

P(A+B)

= P(A)

+ P(B)

– P(AB)

.

4.Основные

правила комбиноторики:«правило суммы»

и «правило произведения» Комбинаторика

– это наука о том, сколько различных

комбинаций удовлетворяющих условиям

можно составить на элементах конечного

множества. Комбинаторные схемы:

Правило

суммы: X

– конечное множество

X=n

– количество элементов.

Объект

x

из X

может быть выбран n-способами.

Пусть X1,…,Xk

попарно непересекающиеся множества,

то есть XiXj=,

ij

тогда очевидно выполняется равенство.

– правило

суммы

Правило

произведения:Если

объект x

может быть выбран m-способами

и после каждого из таких выборов

объект y

может быть выбран n-способами.

Тогда выбор упорядоченной пары (x,y)

может быть осуществлен – mn

способами. Доказательство: Воспользуемся

правилом суммы. {a1,…,am}–

множество элементов, из которых

выбирается объект x.i=1,..,m,рассмотрим

множество Xi={(ai

,y)},

тогда первая компонента совпадает с

ai.

Множества Xi

попарно не пересекаются. Xi=n.

Множество

пар Xi—это

объед.

В

общем случае правило произведения

формируется следующим образом: Если

объект x1

может

быть выбран n1

– способами, после чего объект x2

может быть выбран n2

способами и i,

где i=1,..,m-1

(2

i

m-1)

после выбора объектов x1,…,xi

объект xi+1

может быть выбран ni+1-способами,

то выбор упорядоченной последовательности

x1,…,xm

может быть осуществлен n1,…,nm

способами. Доказательство проводится

методом математической индукции.

10.Формулы

Байеса Теорема.Если

A1,…,An

– разбиение

и все

,

тогда имеет место следующая формула:

Доказательство:

По теореме

умножения:

Формулы Байеса

можно интерпретировать следующим

образом: назовём Ai

– гипотезой, а B

– результат некоторого эксперимента,

a

P(Ai)

– априорные вероятности, а условные

вероятности–апостериорные

вероятности (послеопытные

вероятности).Формулы Байеса позволяют

по априорным и условным вероятностям

вычислить апостериорные вероятности

гипотез. Пример:Детали,

изготовленные цехом завода, попадают

к одному из двух контролёров для

проверки на стандартность. Вероятность

того, что деталь попадёт к первому

контролёру – 0,6; ко второму контролёру,

соответственно, – 0,4. Вероятность

того, что годная деталь будет признана

стандартной, для первого контролёра

– 0,9; для второго – 0,98. Годная деталь

была признана стандартной. Найти

вероятность того, что её проверил

первый контролёр. Решение.

A1={деталь

проверил первый}

A2={деталь

проверил второй}

A1A2=,

A1+A2=

B={годная

деталь признана стандартной}

11. Независимость

событий Если

события A

и B

таковы, что P(B)>0

P(AB)

Определение.

Событие A

не зависит от события B,

если P(AB)

= P(A)

Если потребовать условия P(A)>0,

то

Понятие того,

что одно событие зависит от другого,

симметрично. Замечание

Из теоремы

умножения: P(AB)=P(B)

P(AB)

P(AB)=P(B)

P(A)

Это приводит к определению.

ОпределениеСобытия

A

и B

называются

независимыми,

если вероятность произведения событий

равна произведению вероятностей

событий (P(AB)=P(A)P(B)).

Если событие A

не зависит от события B,

то они являются просто независимыми.

Если P(AB)=P(A)P(B)

не

выполняется, то события являются

зависимыми.

P(AB)=P(A)P(B)–теоретико-вероятностная

(статистическая) независимость; её

следует отличать от причинной

независимости реальных явлений.

Причинная независимость реальных

явлений не устанавливается с помощью

этого равенства, а постулируется на

основе других внешних соображений.

Определение

(Независимость событий в совокупности)

События A1,…,An

называются независимыми, если

индексов 1i1<

i2<…<

imn,

где 2mn,

то выполняется:

В противном

случае — события зависимы. Замечание.Из

определения независимости событий

в совокупности следует, что события

любого подмножества

множества A1,…,An

будут независимы в совокупности.

Пример.

Имеются 4 числа: 2, 3, 5, 30. Наудачу

выбирается одно число. Вероятность

этого события – 0,25. Ak={выбранное

число делится на k}.

Решение.P(A2)=1/2;

P(A3)=1/2

; P(A5)=1/2;

P(A30)=1/2

P(A2A3)=1/4;P(A2A5)=1/4;P(A3A5)=1/4;P(A2A3A5)=1/4

P(A2A3)=P(A2)P(A3)

P(A2A5)=P(A2)P(A5)

— попарно

независимы

P(A3A5)=P(A3)P(A5)

P(A2)P(A3)

P(A5)=0.5*0.5*0.5=1/8

P(A2A3

A5)=1/4

(в совокупности

зависимы).

Совокупная

независимость более сильное свойство,

нежели попарная независимость.

Теорема.Если

события A1,…,An

являются

независимыми, индексы i1,…,in

, j1,…,jk

– все различны, вероятность

,

тогда:

14. Непрерывная

СВ. Плотность распределения.

Опр.Функция

есть плотность распределения СВ X,

если

(***)

Из определения

(***) следуют свойства плотности

распределения.

Свойства

1.

Замечание.

Для

СВ X

имеющей функции. Плотности из свойства

1 и теоремы из курса математического

анализа (о непрерывности интеграла

с переменным верхним пределом)

что

непрерывна.

2.

в точках непрерывности

.

3.

4.

,

т.к.

неубывающая функция, то

.

5.

Условия нормировки:

.

Опр.

СВ X

называется СВНТ,

если ее распределение имеет функцию

плотности

.

Через

плотность

можно выразить любую вероятность

17.Мода, медиана

и квантили

МО не единственная

характеристика положения, применяемая

в теории вероятностей.

Опр.

Модой

СВДТ Х

называется такое возможное значение

xm,

для которого

=xm.

Модой

СВНТ Х

называется действительное число dX,

являющееся точкой максимума функции

плотности вероятностей (fX

(x))

Пример.

X

0 1 2 3 4

P

0,05 0,3 0,25 0,2 0,2

dX=1

Замечание.

Мода может не

существовать, иметь единственное

значение, такие распределения

называются унимодальное, или иметь

множества значений – полимодальное

распределение.

Наличие более

чем одной моды, часто указывает на

разнородность статистического

материала, который положен в основу

исследований.

Опр.Медианой

СВ Х

называется действительное число hX,

удовлетворяющее условию:

,

то есть это корень уравнения FX

(x)=1/2.

Эта

характеристика применяется, как

правило, только для СВНТ и геометрически

медиана, это абсцисса той точки на

оси ОХ, для которой площади под графиком

fX

(x)лежащие

слева и справа от нее одинаковы и

равны 1/2

Замечание.

В случае

симметричного распределения (имеющего

моду) три характеристики: 1) МО ; 2) мода;

3) медиана совпадают.

Замечание.

Уравнение

Fx(x)=1/2

может иметь множество корней, поэтому

медиана может определяться неоднозначно.

Опр.

Квантильлью

порядка р распределения

СВНТ Х

называется действительное число tp,

удовлетворяющее уравнению P{X<tp}=p

Замечание.

Медиана

hx=t0,5

– квантиль порядка 0,5.

22.Локальная

предельная теорема Муавра-Лапласа.

Биномиальное

распределение имеет МО равное np

.

Пусть

p

– не близко к 0 и 1.

Теорема.

Если

в схеме независимых испытаний

,

то для любого C>0

равномерно по всем

вида

,

где m

– неотрицательные целые числа

Замечание.

Эти

таблицы даются, только для x>0.

18.Целочисленные

СВ и их производящие функции

В ряде случаев

при определении важнейших числовых

характеристик дискретных СВ может

помочь аппарат производящих функций.

Опр.

Дискретную

СВ Х,

принимающую только целые, неотрицательные

значения называют целочисленной

СВ.

Закон

распределения целочисленной СВ

определяется

.

Закон распределения

целочисленной СВ удобно изучать с

помощью производящей функции, которая

определяется, как

.

В

соответствии с определением МО:

.

Этот

ряд сходится абсолютно при

.

Поскольку

,

то между законом распределения

и производящими функциями

устанавливается взаимноодноз-начное

соответствие.

Замечание

– вероятностная производящая функция.

В математике

рассматриваются произвольные

производящие функции.

a0,

a1

,a2…

a0

+Sa1

+S2a2

+… –

производящая функция, если она имеет

не нулевой радиус сходимости.

Замечание

Возьмем

первую производную по S

от производящей функции.

,подставим

значение S

= 1.

.Возьмем

вторую производную по S

от производящей функции

То есть можно

выразить начальные моменты более

высокого порядка, через начальные

моменты более низкого порядка.

23 Интегральная

предельная теорема Муавра-Лапласа

Теорема.

При

равномерно

по

Замечание.

– затабулирована.

Ее значения

приводятся только для 0

x3,5.

Ф(–x)=1–

Ф(x)

Пример.Вероятность

изделию некоторого производства

оказаться бракованным равна 0,005 (p

= 0,005).Чему

равна вероятность, что из n

= 10000 наудачу взятых изделий, бракованных

окажется не более 70 (m

= 70).

– ?

24.Геометрическое

распределение

Опр.СВДТ

Х имеет геометрическое распределение,

если ее возможные значения 0, 1, 2, …,

m,

…, а вероятности этих значений

Комментарий

Вероятности

Pm

для последовательных значений m

образуют геометрическую прогрессию

с первым членом p

и знаменателем q.На

практике геометрическое распределение

появляется в следующих условиях.

Пусть производится ряд независимых

испытаний (опытов) с целью получения

какого-то результата (“успеха”) А.

При каждом опыте “успех” достигается

с вероятностью p.

СВ Х

– это число безуспешных опытов до

первой попытки, в которой появляется

результат А.

Ряд распределения

имеет следующий вид.

X 0

1 2 … m ….

P p

qp q2p

… qmp

…

Найдем числовые

характеристики СВ Х

распределенной по геометрическому

закону.

;

mX=q/p

;

;

На практике чаще

приходится рассматривать не СВ Х,

имеющую геометрическое распределение,

а

Y=X+1

– это число попыток до первого успеха,

включая удавшуюся.Ряд распределения

Y

1 2 … m

….

P

p

qp

… qm–1p

…

–геометрическое

распределение,сдвинутое на 1

(геометрическое плюс1).

mY=M[X+1]=M[X]+1=q/p+1=1/p

DY=D[X+1]=D[X]=q/p2

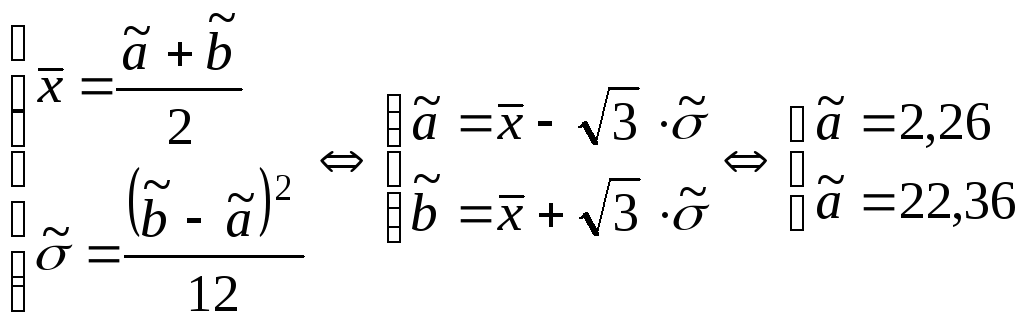

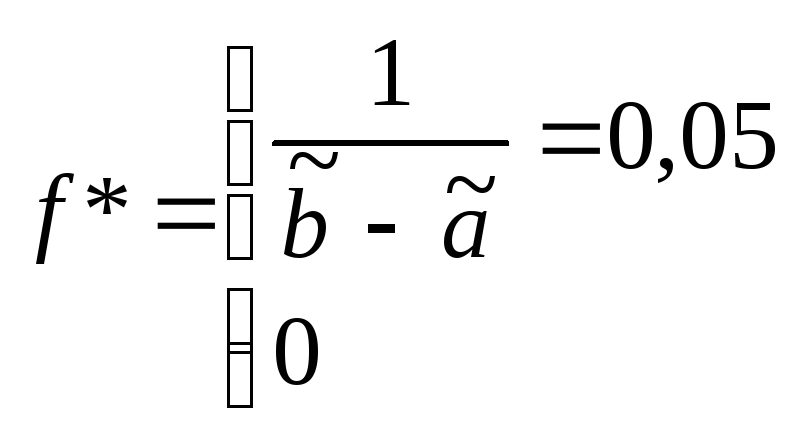

25. Равномерное

распределение

Опр.

СВНТ Х

называется распределенной равномерно

на [a,b],

если fX(x)=0

(при x[a,b])

fX(x)=C

(при x[a,b]),

X~R(a,b).

Найдем

константу С.

;

;

C=1/(b–a).

Пример.Шкала

измерительного прибора проградуированных

в некоторых единицах. СВ Х – ошибка

при округлении отсчета до ближайшего

целого деления, то она будет иметь

равномерное распределение на (-1/2 ;

1/2).Найдем mX,

DX,

X

– ?

Решение.

Замечание.

Моды

равномерное распределение не имеет,

а медиана совпадает с МО. hX=mX

=(a+b)/2.

Найдем

функцию распределения и построим ее

график.

FX(x)=P{X<x}

1)Случай.

2)Случай

3)Случай

29.

Совместная

функция распределения

Пусть на одном

и том же вероятностном пространстве

(,A,P)

задано n

СВ,

,

совокупность

– называется многомерной (n-мерной)

СВ или случайным вектором.

Совместная

функция распределения:Рассмотрим

в одном и том же вероятностном

пространстве (,A,P)

набор СВ

.

Так как множество

,

таких пересечения

, поэтому существует вероятность

этого события, которая называется

многомерной функцией

распределения.Замечания:1.В

дальнейшем ограничимся случаем двух

случайных величин

.

2.

Функция

– вероятность того, что случайная

точка

попадает в бесконечный квадрант с

вершиной в точке

.

С помощью F,

можно вычислить вероятность попадания

случайной точки в полуполосу или в

прямоугольник.

а)

б)

в)

Свойства.

1.

по каждому аргументу не

убывает и непрерывна

слева.

2.

.

3.

.

4. а) При

становится функцией распределения

компоненты x.

.

б) При

становится функцией распределения

компоненты y.

.

34.

Мультипликативные свойства

математических ожиданий, аддитивное

свойство дисперсии

Теорема.

Если СВ X

и Y

независимы,

то M[XY]=M[X]*M[Y].

Доказательство:

Ограничимся

случаем двух дискретных СВ принимающих

конечное множество значений, тогда

В силу аддитивности

МО,

Так как СВ

независимы, то

.

Следствие:

Если СВ

– независимы, то

(доказательство проводится методом

математической индукции).

Из

мультипликативного СВ МО

аддитивное свойство дисперсии.

Теорема. Если

СВ X

и Y

независимы, то D[X+Y]=D[X]+D[Y].

Доказательство:

D[X+Y]=M[((X+Y)–(mX

– mY))2]=

M[((X–

mX)+(

Y

– mY))2]=

M[(X–

mX)2+

2(X– mX)(

Y

–

mY)+

(Y

–

mY)2]=

DX+DY+2

M[(X– mX)(Y

–

mY)]

Так как X

и Y

независимы, то X–

mX

и Y

– mY

независимы

D[X+Y]=DX+DY+2

M[(X– mX)(Y

–

mY)],

где

X–

mX=MX

– mX=0

и MY

– mY=0

D[X+Y]=

DX+DY

.Следствие:

Если СВ X1,

X2

,..,Xn

– независимы, то

37.

Условное МО . Регрессия.

Опр.

Условным математическим ожиданием

одной из СВ входящих в систему (X;

Y)

называется ее МО вычисленное при

условии, что другая СВ приняла

определенное значение. Замечание.

То есть МО найденное на основе условного

закона распределения. Если СВ

дискретные, то

Если СВ X

и Y

непрерывные, то

Опр

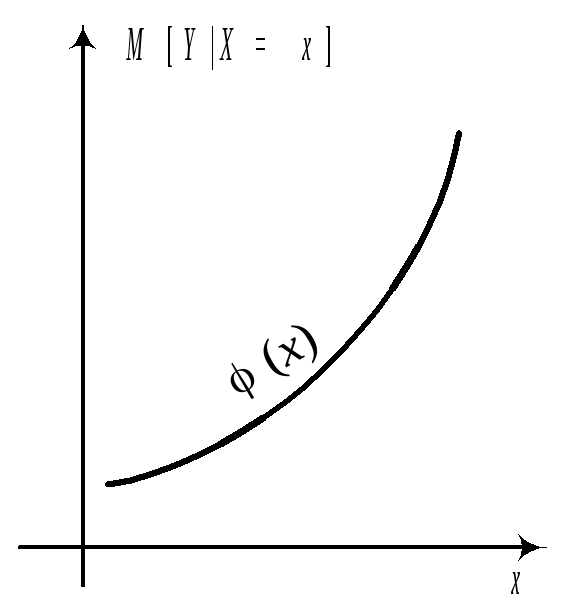

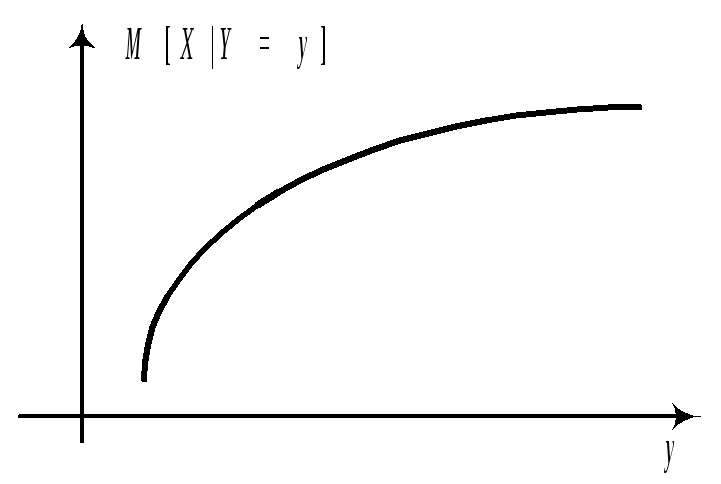

M[YX=x]=(x)

называется регрессией Y

на x.

M[XY=y]=(y)

называется

регрессией X

на y.

Графики этих

зависимостей от x

и от y

называются линиями регрессии или

кривыми регрессии.

Замечание.

Для независимых СВ линии регрессии

Y

на x

и X

на y

параллельны координатным осям так

как МО каждой из них не зависит от

того, какое значение приняла другая.

Линии регрессии

могут быть параллельны координатным

осям и для зависимых СВ, когда МО

каждой из них зависит от того, какое

значение приняла другая.

Так

как все моменты начальные и центральные

любых порядков представляют собой

МО, то можно говорить об условных

моментах. Например об условных

дисперсиях D[YX=x],

D[XY=y],.

38.Двумерные

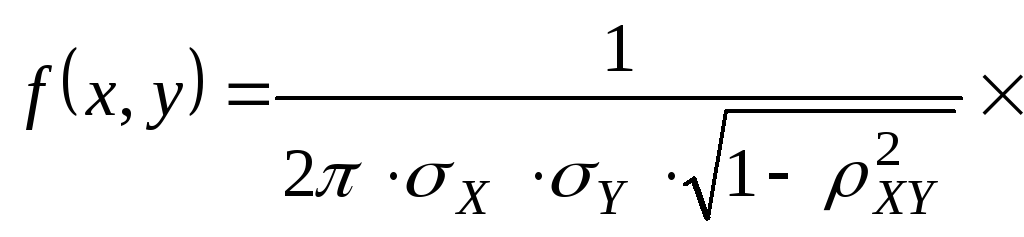

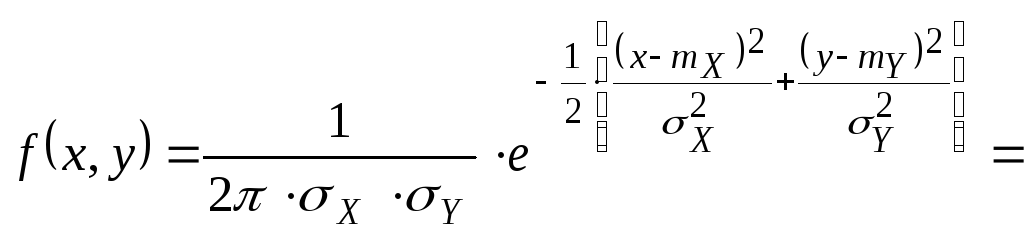

нормальные распределения. Опр.Нормальным

законом распределения на плоскости

называется распределение вероятностей

двумерной СВ (X,

Y),

если

Итак,нормальный

закон на плоскости определяется 5-ю

параметрами: mX;

mY;

Y;

Y;

XY

. Убедимся

в том, что если компоненты X

и Y

не коррелированны, то они тогда и не

зависимы.

XY=0

Замечание:

Для нормально распределенных компонент

двумерной СВ понятие независимости

и некоррелированности равносильны.

Найдем

условные законы распределения СВ X

и Y

воспользовавшись формулами.

.

.

Как легко видеть,

каждый из условных законов распределения

является также нормальных с условным

МО и условной дисперсией вычисляемым

по формуле:

Замечание.

Из двух формул для условного МО видно,

что для системы нормально распределенных

X

и Y,

линии регрессии Y

на x

и X

на y

представляют собой прямые линии, то

есть регрессия всегда линейна.

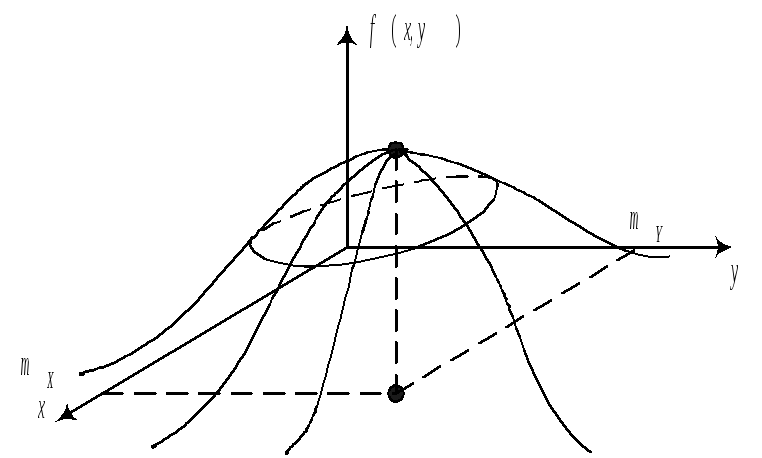

В геометрической

интерпретации график линейной формулы

плотности представляет собой

холмообразную поверхность.

.

Сечение

поверхности

плоскостями параллельными плоскости

XOY

представляют собой эллипсы.

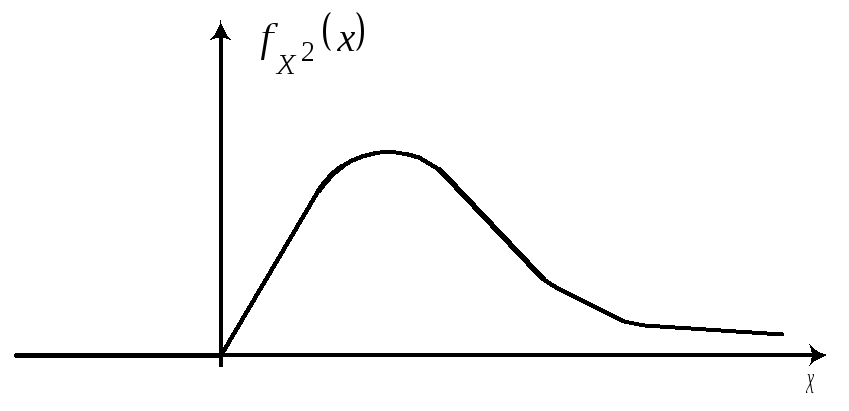

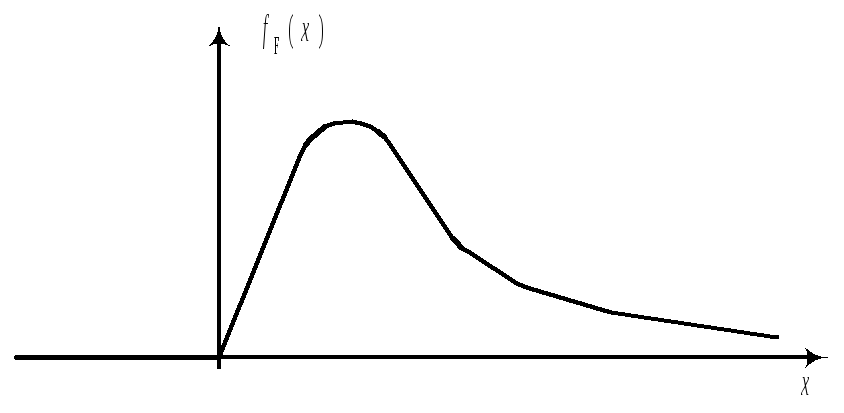

41.Распределение

2.

(“хи-квадрат”).

Пусть

Zi

~N(0;1)

, i=1,2…k,

тогда

–называется

СВ распределенной по закону 2

с k

степенями свободны.

,

.

Распределение

2

определяется одним параметром числом

степеней свободы. С увеличением

степеней свободы распределение 2

медленно приближается к нормальному.

На практике при k

> 30 считают, что

,

где

.Для

СВ, имеющей 2

распределение существуют таблицы

квантилей.

43.

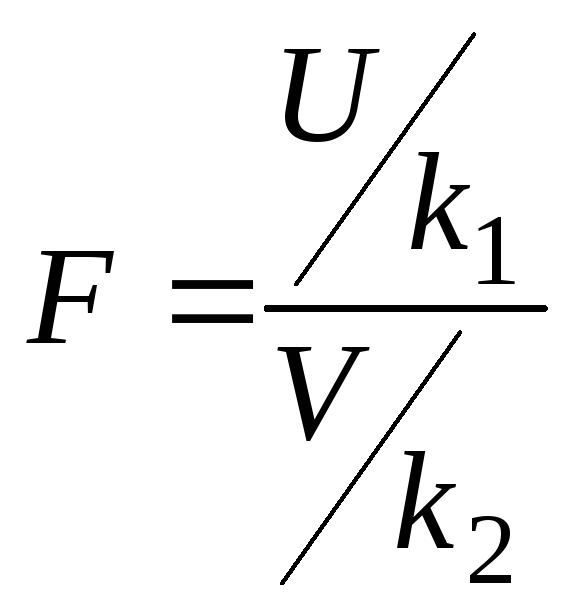

Распределение Фишера.Если

U

и V

независимые СВ, распределенные по

закону 2,

,

,

тогда

имеет распределение, которое называется

F–распределением

или распределением Фишера со степенями

свободы k1

и k2.

(

F–распределение

определяется двумя параметрами k1

и k2

и существует таблица квантилей..

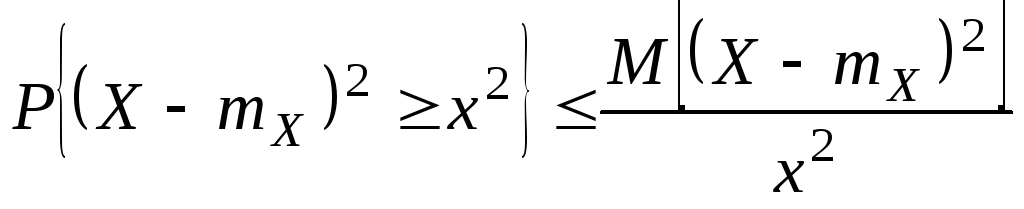

44.

Неравенства Чебышева. Следующие

два неравенства называют неравенствами

Чебышева. Сформулируем их в виде

теорем. Теорема:

x>0

имеют место неравенства:.

Доказательство:

Разложим X

в сумму двух слагаемых

,

так как x

> 0, получаем

.

.

Замечание.

Очень часто второе неравенство

Чебышева дают в такой форме

.

Второе

неравенство Чебышева показывает, что

при малой дисперсии с вероятностью

близкой к 1 СВ Х

концентрируется около своего МО.

48.Статистическое

описание и вычисление оценок параметров

распределения системы двух СВ.

Пусть исход некоторого эксперимента

описывается двумя СВ (X;

Y).Предварительное

представление о зависимости между X

и Y

можно получить, нанося элементы

двумерной выборки (xi

,

yi

)

, i=1,..,n,

в виде точек на плоскость с выбранной

системой координат. Такое представление

называется диаграммой рассеяния.

Опр.

Распределением двумерной выборки

называется распределение двумерного

дискретного СВ случайного вектора,

принимающего значения (xi,,

yi)

с вероятностями 1/n.

Выборочные числовые характеристики

вычисляются как соответствующие

числовые характеристики двумерного

дискретного случайного вектора. Если

объем выборки небольшой, то тогда

вычисления проводятся в следующей

последовательности:

1.

.

Контроль

.

2. Суммы квадратов

отклонений от среднего и произведения

отклонений от среднего

.

3.

;

;

.

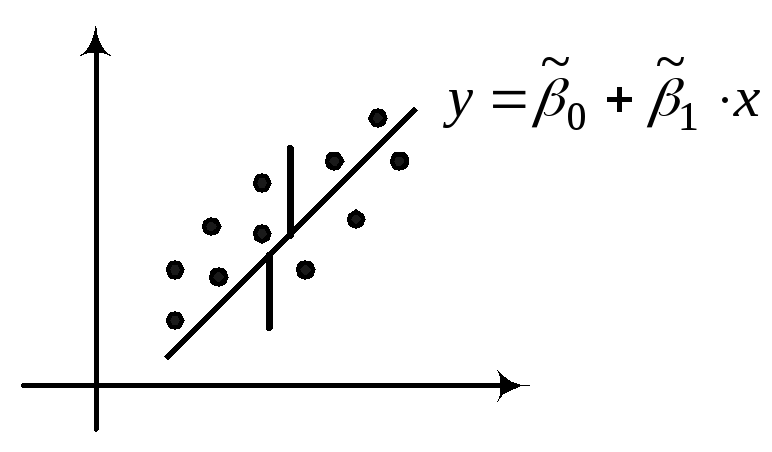

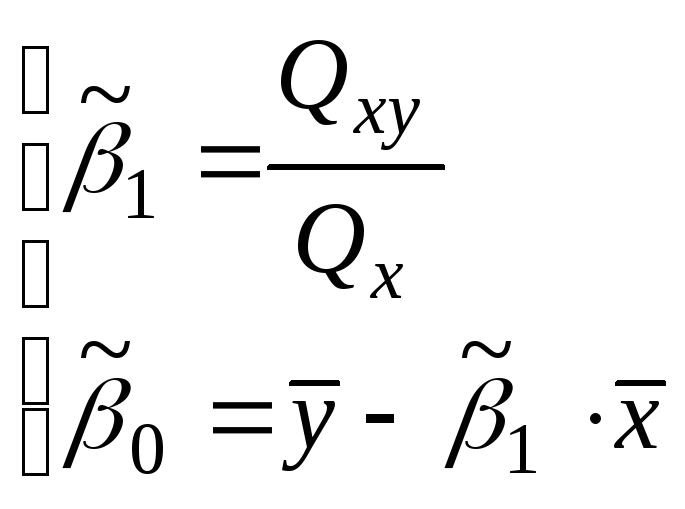

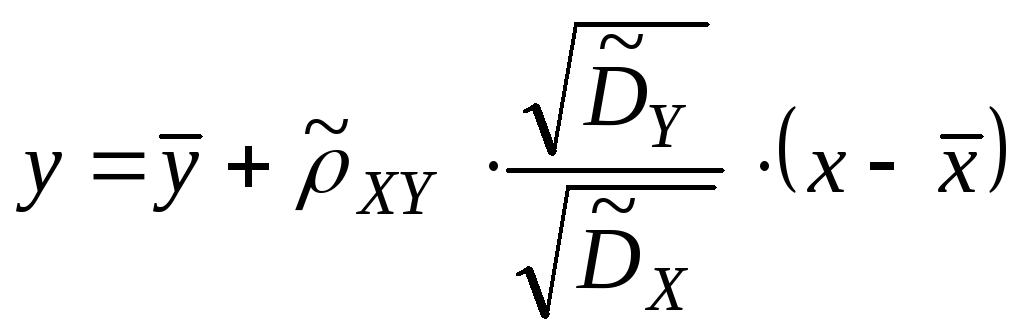

49.

Линии регрессии

Для СВ X

и Y.

Регрессией Y

на X

называется условное МО

.

используется

для предсказания значения СВ Y

по фиксированному значению СВ X.

Если

,

то говорят о линейной регрессии Y

на X.

– прямая регрессии.

Оценки параметров

линейной регрессии по выборке (xi

,

yi

)

, i=1,..,n

можно получить, используя МНК из

условия минимума суммы

.

коэффициенты регрессии.

;

Выборочная

линейная регрессия Y

на X.

Аналогично рассматривается X

на Y.

;

;

.

Обе прямые

регрессий пересекаются в точке с

координатами

.

Угол между этими двумя прямыми

уменьшается при увеличении коэффициента

корреляции. При

обе прямые совпадают. Замечание

Прямые

и

должны быть различны.

52.

Интервальные

оценки. Доверительный интервал.

Доверительная вероятность.

В ряде задач

требуется не только найти для параметра

подходящую оценку

,

но и указать к каким ошибкам может

привести замена параметра

его оценкой

,

т.е. требуется оценить точность и

надежность оценки.

Для определения

точности оценки

в статистике пользуются доверительными

интервалами.

Для определения

надежности оценки

в статистике пользуются доверительной

вероятностью.

Опр.

Доверительным интервалом для параметра

называется интервал

,

содержащий истинное значение параметра

с заданной вероятностью

.

.

Опр.

Число

называется доверительной вероятностью,

а значение

– уровнем значимости.

Замечание.

Нижняя

и верхняя

граница доверительного интервала

определяется по результатам наблюдений

и следовательно является СВ. Поэтому

так и говорят, что доверительный

интервал «накрывает» оцениваемый

параметр с вероятностью

.

Выбор доверительной

вероятности каждый раз определяется

конкретной постановкой задачи. Обычно

р

= 0,9; р

= 0,95; р

= 0,99.

Часто применяют

односторонние доверительные интервалы

(левосторонний),

(правосторонний).

В

простейших случаях метод построения

доверительных интервалов состоит в

следующем

–оценка

,

.

Предположим, что существует непрерывная

и монотонная функция Y,

зависящая от

и

,

но такая, что ее распределение не

зависит от

и других параметров. Для нахождения

границ доверительного интервала

по заданной доверительной вероятности

.

В этом случае можно использовать

неравенство

,

где числа

,

определяются из условия

Рассмотрим

нахождение доверительного интервала

для среднего и дисперсии нормально

распределенной генеральной совокупности.

53. Доверительный

интервал для оценки МО при известной

дисперсии

1)

Доверительный

интервал для оценки МО при известной

дисперсии нормально распределенной

генеральной совокупности.

Пусть

– выборочный вектор n–наблюдений

СВ Х,

где

.

В качестве оценки для m

возьмем

.

Предположим, что

известна. Рассмотрим статистику

Статистика

.

По

таблице нормального распределения

найдем квантили

и

.

.

.

.

Учитывая,

что

получаем

.

57.

Критерий

и его применение.

Критерий

применяется в частности для проверки

гипотез о виде распределения генеральной

совокупности.

Процедура

применения критерия

для проверки гипотезы H0,

утверждающей, что СВ Х

имеет закон распределения

состоит из следующих этапов.

Этапы:

-

По

выборке найти оценки неизвестных

параметров предполагаемого закона

.

-

Если

Х–СВДТ – определить частоты

,

i

= 1, 2, …, r,

с которым каждое значение встречается

в выборке.

Если

Х–СВНТ – разбить множество значений

на r

– непересекающихся интервалов

и попавших в каждый из этих интервалов

-

Х–СВДТ

вычислить

.

Х–СВНТ

вычислить

.

-

.

-

Принять

статистическое решение.

– гипотеза

Н0

– принимается.

– гипотеза

Н0

– отклоняется.

e

– количество оцениваемых параметров.

Малочисленные

частоты надо будет объединять.

Проверка гипотезы

о равномерном распределении генеральной

совокупности.

n

= 200

А;

|

№ |

(xi-1, |

ni |

|

|

1 |

2 – |

21 |

|

|

2 |

4 – |

16 |

|

|

3 |

6 – |

15 |

|

|

4 |

8 – |

26 |

|

|

5 |

10 – |

22 |

|

|

6 |

12 – |

14 |

|

|

7 |

14 – |

21 |

|

|

8 |

16 – |

22 |

|

|

9 |

18 – |

18 |

|

|

10 |

20 – |

25 |

1.

2.

|

|

|

|

|

21 |

17,3 |

0,79 |

|

16 |

20 |

0,8 |

k

= 10 – 2 – 1 = 7

– нет

основания отвергать гипотезу о том,

что выборка взята из генеральной

совокупности и имеет равномерное

распределение.

5-6..Размещения

и сочетания

Набор

элементов xi1,

xi2,

…, xin

из множества X={x1,…,xn}

называется выборкой объема r

из n-элементов

<n,

r>-выборка.

Выборка называется упорядоченной,

если порядок следования элементов в

ней задан. Замечание:Две

упорядоченные выборки, различающиеся

лишь порядком следования элементов,

считаются различными. Если порядок

следования элементов не является

существенным, то выборка называется

неупорядоченной.

В выборках могут допускаться или не

допускаться повторения элементов.

Упорядоченная

<n,

r>-выборка,

в которой элементы могут повторяться,

называется<n,

r>-размещением

с повторениями. Упорядоченная<n,

r>-выборка

элементы, которой попарно различны,

называется <n,

r>размещением

без повторений (<n,

r>размещением).Замечание<n,n>-размещения

без повторений называются перестановками

множества X.Неупорядоченная<n,r>-выборка,

в которой элементы могут повторяться,

называется <n,

r>-сочетанием

с повторениями. Неупорядоченная

<n,

r>-выборка

элементы, которой попарно различны,

называется <n,

r>-сочетанием

без повторений (<n,

r>-сочетанием).Замечание:Любое

<n,

r>-сочетание

можно рассматривать, как r-элементное

подмножество n-элементного

множества.

Теорема

1:=

nr

Доказательство:

Каждое <n,r>-размещение

с повторениями является упорядоченной

последовательностью длины r.

Причем каждый элемент этой

последовательности может быть выбран

n-способами.

По правилу произведения получаем

=

nnn

.. n

=nr

.

Теорема

2:.

Доказательство:Каждое

<n,r>-размещение

без повторений является упорядоченной

последовательностью длины r.

По правилу произведения получаем

.

Теорема 3:

Доказательство:Каждое

<r,r>-сочетание

без повторений можно упорядочить

r!-способами.

Объединение получаемых таким образом

попарно непересекающихся множеств

<n,r>-размещений

без повторений для всевозможных

<n,r>-сочетаний

без повторений, даст все <n,r>-размещения

без повторений.

(суммирование

производится по всевозможным

<n,r>-сочетаниям

без повторений).

.

Теорема

4:=

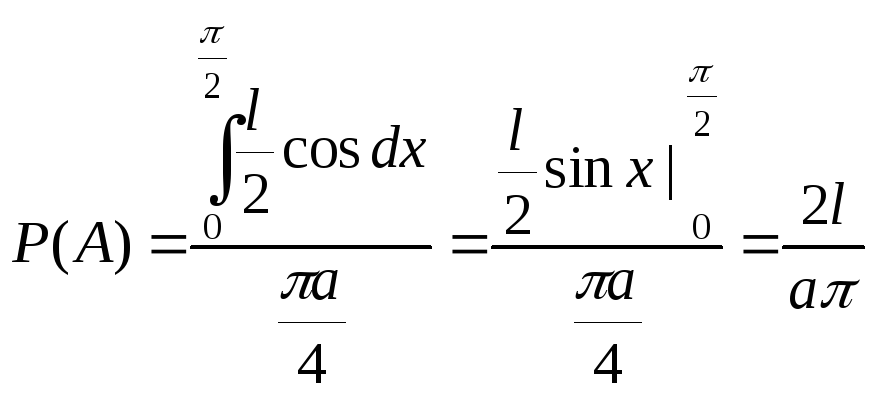

7. Геометрические

вероятности .Задача Бюффона.Геометрические

вероятности –

класс моделей вероятностных пространств,

дающий геометрические вероятности.

Пусть Ω={ω} – ограниченное множество

n-мерного

евклидова пространства с конечным

n-мерным

объёмом. Событиями назовём подмножества

Ω, для которых можно определить

n-мерный

объём. Для любого A

A

положим P(A)=A/

Ω ,

где |V|-n-мерный

объем множества V

A.Это

вероятностное пространство служит

моделью задач, в которых частица

случайно бросается в область Ω.

Предполагается, что положение частицы

равномерно распределено на множестве

Ω, т. е. вероятность попадания частицы

в подмножество A

пропорциональна n-мерному

объёму этой области. Замечание:В

классе конечных вероятностных

пространств в систему A

входили все подмножества Ω. При

геометрическом определении вероятности

в качестве A

уже нельзя

взять все подмножества Ω, так как

некоторые из них не имеют n-мерного

объёма. Примеры:

1) Стержень

разламывается на две части в случайной

точке, равномерно распределённой по

длине стержня. Найти вероятность

того, что длина меньшего обломка

окажется не больше трети длины всего

стержня.

Обозначим

за x

расстояние от фиксированного конца

стержня до точки излома.

Задача

Бюффона:Плоскость

расчерчена па-раллельными прямыми,

расстояние между которыми равно a.

На плоскость наудачу брошена игла

длины l

(l<a).

Найти

вероятность того, что игла пересечет

какую-либо прямую. Решение:. Пусть y

– расстояние от центра иглы до

ближайшей прямой (0y

a/2),

а x

– ост-рый угол, составленный иглой с

этой прямой (0x

π2).

Пара чисел (x,

y)

задаёт положение иглы с точностью до

выбора конкретной прямой.

–игла

пересекает прямую.

12. Случайные

величины и законы их распределения

Пусть

(Ω, A,

P)–произвольное

вероятностное пространство. Определение:

Числовая функция X=X()

от элементарного события

называется случайной величиной (СВ),

еслиxR:

{X<x}={X()<x}

A

(*) Комментарий:

Смысл определения состоит в следующем:

поскольку не любое подмножество

пространства Ω

является

событием, и все события составляют

-алгебру

подмножества A,

то, естественно, рассматриваются

только такие функции X=X(),

для которых имеет смысл говорить о

вероятности попадания X=X()

в достаточно

большие числовые множества. Свойство

(*)

гарантирует, что для любого X

неравенство X<x

есть